在当今的深度学习领域,PyTorch 和 PyG(PyTorch Geometric)的结合为处理图数据提供了强大的工具,要想充分发挥它们的优势,优化模型训练是至关重要的。

模型训练的优化并非一蹴而就,需要综合考虑多个方面,数据预处理是一个关键环节,高质量、规范化的数据能够为模型训练提供良好的基础,在对数据进行清洗和预处理时,要去除噪声、异常值,并进行适当的标准化或归一化操作,以确保数据的分布合理,从而提高模型的学习效率和泛化能力。

超参数的调整也是影响模型训练效果的重要因素,学习率、批次大小、网络层数和神经元数量等超参数的选择需要根据具体的问题和数据特点进行精细的调试,学习率过高可能导致模型无法收敛,而过低则会使训练过程变得缓慢,通过试验不同的超参数组合,并观察模型在验证集上的性能,可以找到最优的配置。

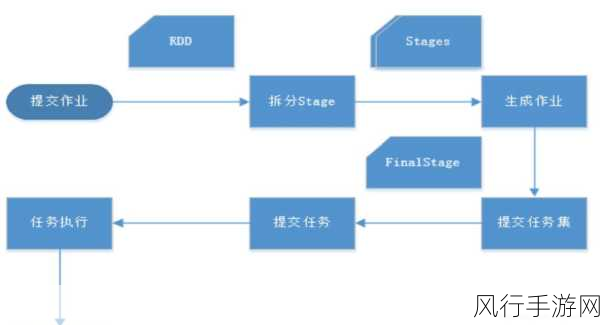

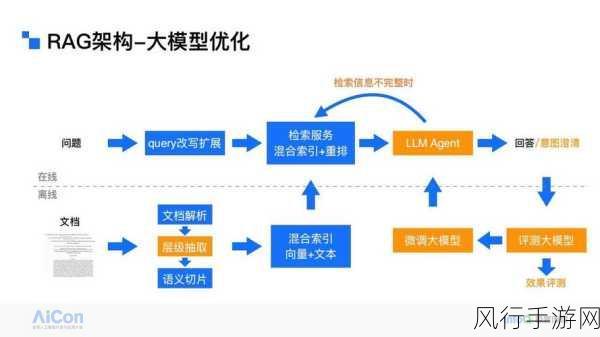

模型结构的设计同样不容忽视,合理选择合适的神经网络架构,如卷积神经网络、循环神经网络或图神经网络等,要结合数据的特征和任务的需求,对于图数据,PyG 提供了丰富的图卷积模块和消息传递机制,但如何巧妙地组合和运用这些模块,以构建高效且准确的模型,需要深入的理解和实践经验。

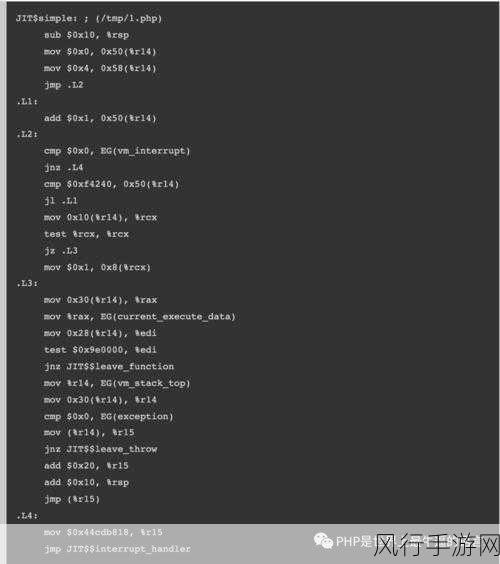

硬件加速技术的应用也能显著提升训练速度,利用 GPU 进行并行计算,能够大大缩短训练时间,在代码实现中,要确保正确配置 GPU 环境,并充分利用 PyTorch 提供的 CUDA 相关接口和优化函数。

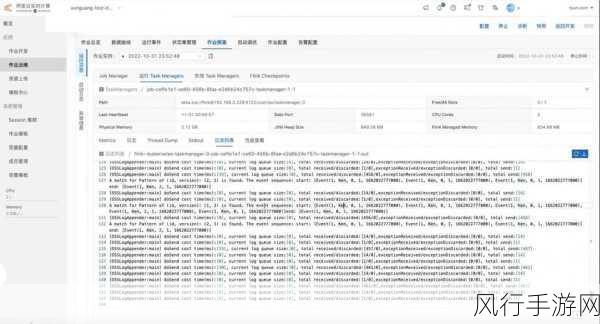

在模型训练过程中,监控和评估指标是必不可少的,常见的指标如准确率、召回率、F1 值等,能够直观地反映模型的性能,通过定期观察这些指标的变化,可以及时发现模型训练中的问题,并采取相应的调整措施。

模型压缩和量化技术也是优化的一个方向,通过减少模型的参数数量、降低参数精度等方法,可以在不损失过多性能的前提下,减小模型的存储空间和计算量,从而提高模型的部署效率和运行速度。

优化 PyTorch 和 PyG 中的模型训练是一个综合性的工作,需要从数据、超参数、模型结构、硬件加速、监控评估以及模型压缩等多个角度进行考虑和实践,只有不断探索和尝试,才能找到最适合具体问题的优化方案,让模型在实际应用中发挥出最佳性能。