在当今数字化时代,数据处理的需求日益增长,尤其是在高并发的环境中,如何有效地运用 Flink 窗口函数来应对数据洪流成为了技术人员关注的焦点。

Flink 作为一个强大的流处理框架,其窗口函数为处理实时数据提供了灵活且高效的方式,在高并发场景下,窗口函数的运用面临着诸多挑战。

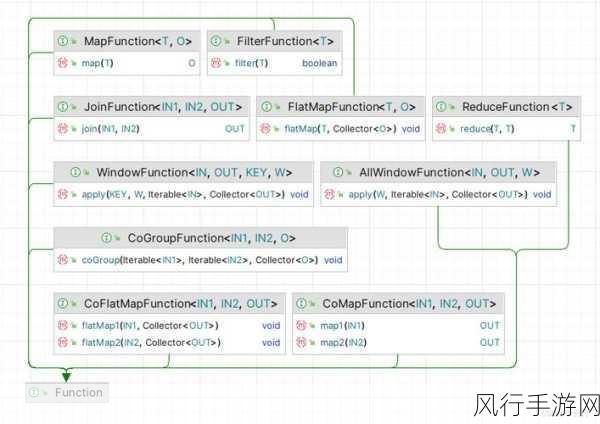

要理解 Flink 窗口函数在高并发场景下的应对策略,我们首先需要明晰窗口函数的基本概念和类型,Flink 中的窗口函数主要包括滚动窗口、滑动窗口、会话窗口等,滚动窗口按照固定的时间或数据量进行划分,每个窗口之间互不重叠;滑动窗口则是在一定的时间间隔内不断滑动,窗口之间存在重叠部分;会话窗口则是根据数据之间的间隔来划分窗口。

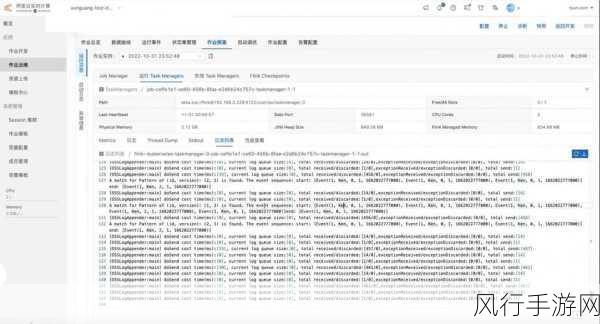

在高并发场景下,数据的流入速度极快,这对窗口函数的性能提出了很高的要求,为了提升性能,一方面需要合理地设置窗口的大小和滑动步长,如果窗口过大或滑动步长过小,可能会导致大量的数据积压,增加处理的延迟;反之,如果窗口过小或滑动步长过大,则可能会丢失一些有价值的信息,优化窗口的触发机制也至关重要,可以根据实际业务需求,选择合适的触发条件,如基于时间、数据量或者其他自定义的条件。

数据的分布不均也是高并发场景中常见的问题,某些窗口可能会接收到大量的数据,而另一些窗口则相对较少,为了应对这种情况,可以采用动态调整窗口资源的策略,根据窗口的数据量动态分配计算资源,确保每个窗口都能够得到及时处理。

在数据处理过程中,还需要考虑数据的准确性和一致性,在高并发环境下,数据可能会出现乱序的情况,这就需要引入适当的乱序处理机制,可以通过设置允许的延迟时间或者使用 Watermark 机制来处理乱序数据,保证窗口计算结果的准确性。

缓存和批处理的结合也是提升性能的有效手段,对于一些频繁访问且计算量较大的数据,可以将其进行缓存,以减少重复计算,在适当的情况下,将小批次的数据进行合并处理,提高处理效率。

要使 Flink 窗口函数在高并发场景下发挥出最佳性能,需要综合考虑窗口的类型和参数设置、资源分配、数据分布、乱序处理以及缓存和批处理等多个方面,只有通过不断地实践和优化,才能在高并发的数据流中挖掘出有价值的信息,为业务决策提供有力支持。