在当今数字化时代,数据已成为企业和组织的重要资产,Hadoop 作为一种广泛应用的大数据处理框架,其核心组件的安全性至关重要,保障 Hadoop 核心组件的安全并非易事,需要我们深入了解其架构和特点,采取一系列有效的措施。

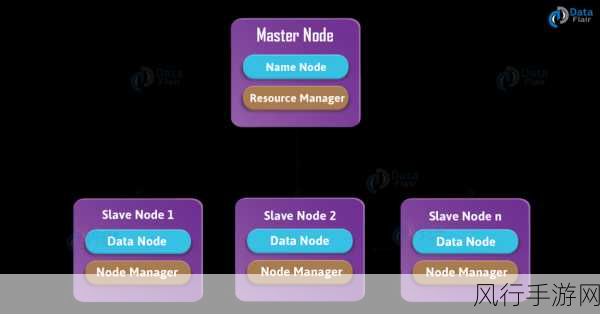

Hadoop 核心组件包括 HDFS(Hadoop 分布式文件系统)、YARN(Yet Another Resource Negotiator,资源管理框架)和 MapReduce(分布式计算框架)等,这些组件协同工作,实现了大规模数据的存储和处理,但与此同时,它们也面临着诸多安全威胁,如未经授权的访问、数据泄露、恶意攻击等。

要确保 Hadoop 核心组件的安全,一个关键的方面是强化身份认证和授权机制,通过实施严格的用户身份验证,只有合法的用户能够访问系统,基于角色的授权策略可以精确控制用户对不同资源和操作的权限,从而避免越权操作。

加密技术也是保障数据安全的重要手段,对存储在 HDFS 中的敏感数据进行加密,可以防止数据在传输和存储过程中被窃取或篡改,在数据处理过程中,采用加密计算技术,能够在不暴露明文数据的情况下进行计算,进一步增强数据的安全性。

网络安全防护不容忽视,设置防火墙、入侵检测系统等网络安全设备,能够有效阻止外部的恶意攻击和非法访问,定期对网络进行安全扫描和漏洞修复,及时发现并解决潜在的安全隐患。

对于 Hadoop 集群的管理和运维,也需要建立完善的安全规范和流程,运维人员应接受安全培训,遵循最佳实践进行操作,避免因人为失误导致的安全问题。

实时监控和审计系统的运行状态也是必不可少的,通过对系统活动的实时监测和日志分析,可以及时发现异常行为,并采取相应的措施进行处理,将安全风险降到最低。

保障 Hadoop 核心组件的安全是一个综合性的工作,需要从多个方面入手,采取多种手段相结合的方式,只有这样,才能构建起坚固的安全防线,让 Hadoop 大数据处理框架在安全的环境下为企业和组织创造价值。