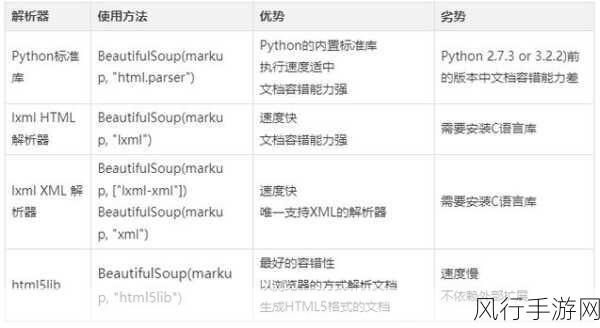

在当今数字化信息时代,Python 爬虫成为了获取大量数据的有效工具,而数据存储作为爬虫过程中的重要环节,有着多种不同的方法可供选择。

Python 爬虫获取到的数据需要妥善存储以便后续的分析和使用,其中一种常见的数据存储方法是使用 CSV(逗号分隔值)文件格式,CSV 格式简单直观,易于处理和共享,通过 Python 的内置库,如pandas ,可以轻松地将爬取到的数据写入 CSV 文件中,在写入时,只需将数据整理成合适的格式,然后调用相应的函数即可完成存储。

另一种常用的存储方式是存储到数据库中,如 MySQL、MongoDB 等,数据库提供了更强大的数据管理和查询功能,适合处理大量且复杂的数据结构,对于关系型数据库 MySQL ,可以使用 Python 的数据库连接库,如pymysql ,来建立连接并执行数据插入操作,而对于非关系型数据库 MongoDB ,则可以借助pymongo 库来实现数据的存储。

JSON(JavaScript 对象表示法)也是一种常用的数据存储格式,它具有良好的可读性和跨平台性,Python 中的json 模块能够方便地将数据转换为 JSON 格式并进行存储,JSON 格式常用于数据的传输和交换,在与其他系统或应用进行数据交互时十分便捷。

除此之外,还可以将数据存储为 Excel 文件,Excel 文件在数据展示和处理上具有一定的优势,尤其是对于需要进行简单数据分析和可视化的场景,通过openpyxl 等库,能够实现将数据写入 Excel 表格。

在选择数据存储方法时,需要根据具体的需求和场景来决定,如果数据量较小且结构简单,CSV 或 JSON 可能是不错的选择;如果需要进行复杂的查询和数据管理,数据库则更为合适;而对于需要与其他办公软件交互或者进行特定格式的数据展示,Excel 则能发挥其作用。

Python 爬虫的数据存储方法多种多样,每种方法都有其特点和适用场景,开发者需要根据实际情况灵活选择,以达到高效、准确地存储和利用爬虫获取到的数据的目的。