在当今数字化时代,数据处理的准确性对于企业和组织的决策至关重要,Flink 作为一种强大的流处理框架,在保障数据准确性方面展现出了卓越的能力。

Flink 能够确保数据准确性的关键之一在于其强大的容错机制,当处理过程中出现故障或错误时,Flink 可以通过检查点(Checkpoint)机制将状态进行保存和恢复,这意味着即使在出现意外情况时,也能够从之前保存的检查点重新开始处理,避免数据的丢失或错误计算。

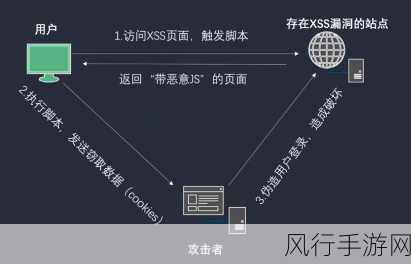

Flink 对数据的一致性有着严格的保障,它通过精确一次(Exactly-Once)语义和至少一次(At-Least-Once)语义等多种模式,来满足不同业务场景对数据处理准确性的要求,精确一次语义确保了每个数据元素在处理过程中只被处理一次,从而避免了重复计算和数据不一致的问题,而至少一次语义则保证了数据不会被遗漏,但可能会存在少量的重复处理。

Flink 提供了丰富的窗口机制,使得数据能够在特定的时间范围内进行聚合和计算,这种窗口化的处理方式有助于在复杂的流数据中准确地提取有价值的信息,并且能够根据业务需求灵活地调整窗口大小和类型,进一步提高数据处理的准确性。

在数据输入阶段,Flink 支持多种数据源,并对数据的质量和完整性进行校验,它可以在数据进入处理流程之前,检测和处理缺失值、异常值等问题,从而从源头上保障数据的准确性。

Flink 还具备良好的监控和告警功能,通过实时监控数据处理的指标和状态,一旦发现数据准确性出现偏差或异常,能够及时发出告警通知,以便相关人员能够迅速采取措施进行修复和调整。

Flink 流处理通过其先进的技术架构和完善的功能特性,为保障数据准确性提供了全方位的支持,在不断变化和增长的数据环境中,Flink 无疑是企业和组织实现高效、准确数据处理的可靠选择。