在当今大数据处理领域,SparkStreaming 以其强大的功能和高效的性能备受关注,而其中的 SparkStreaming SQL 更是为数据处理和分析带来了极大的便利。

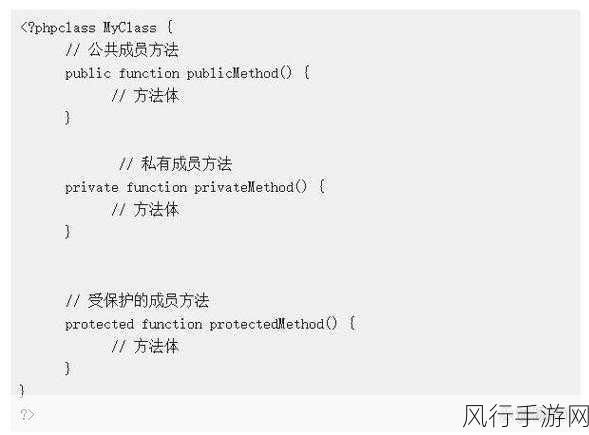

SparkStreaming SQL 是基于 Spark 核心引擎构建的一种实时数据处理技术,它能够在数据流上执行类似传统关系型数据库中的 SQL 操作,从而实现对实时数据的快速分析和处理。

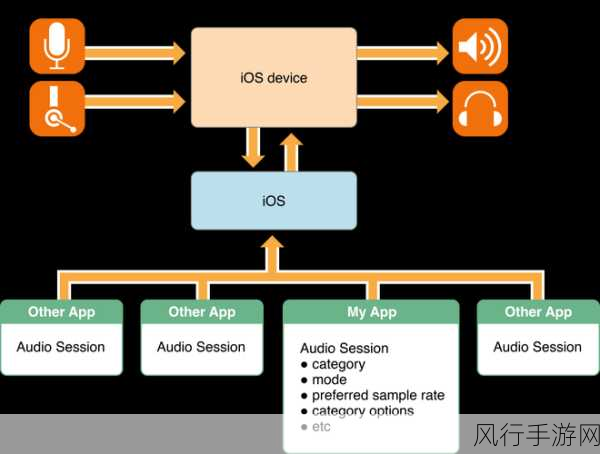

要理解 SparkStreaming SQL 的工作原理,我们需要先了解它的基本架构,它主要由数据源、数据处理引擎和结果输出三部分组成,数据源可以是各种各样的实时数据来源,如 Kafka 消息队列、Flume 等,这些数据源将源源不断的数据输入到 SparkStreaming 中。

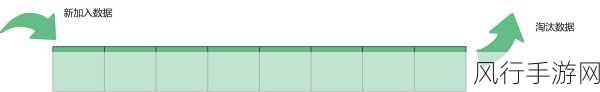

在数据处理过程中,SparkStreaming SQL 会将接收到的数据流进行划分和转换,它会将数据流分割成一系列的小批次,每个批次都被视为一个静态的数据集合,通过 Spark 的计算引擎对这些批次进行处理,执行用户定义的 SQL 操作。

这里面涉及到的关键技术包括窗口操作和状态管理,窗口操作允许我们在一定的时间范围内对数据进行聚合、计算等操作,而状态管理则用于跟踪和保存处理过程中的中间状态,以便进行更复杂的计算和分析。

当数据处理完成后,结果将通过各种输出方式进行展示,可以将结果存储到数据库、文件系统中,或者直接在前端界面进行实时展示。

SparkStreaming SQL 以其独特的工作原理,为实时数据处理提供了强大的支持,它使得开发者能够更加便捷地利用熟悉的 SQL 语言来处理实时数据,大大提高了开发效率和数据处理的准确性,在未来,随着技术的不断发展和应用场景的不断拓展,SparkStreaming SQL 必将发挥更加重要的作用,为大数据领域带来更多的创新和突破。