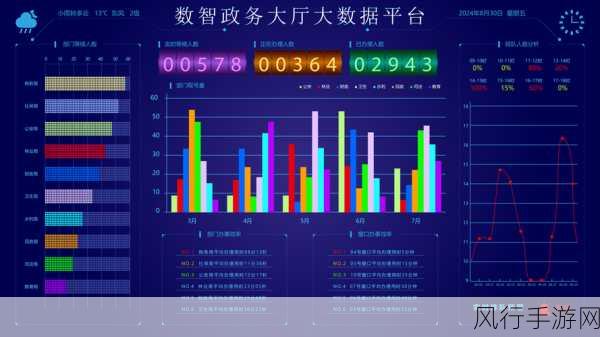

在当今数字化时代,数据量呈现爆炸式增长,服务器端面临着前所未有的海量数据处理压力,如何高效应对这一挑战,成为了众多企业和技术团队亟待解决的关键问题。

大数据的处理并非一蹴而就,它需要综合运用多种技术和策略,从数据的采集、存储到分析和应用,每一个环节都需要精心设计和优化。

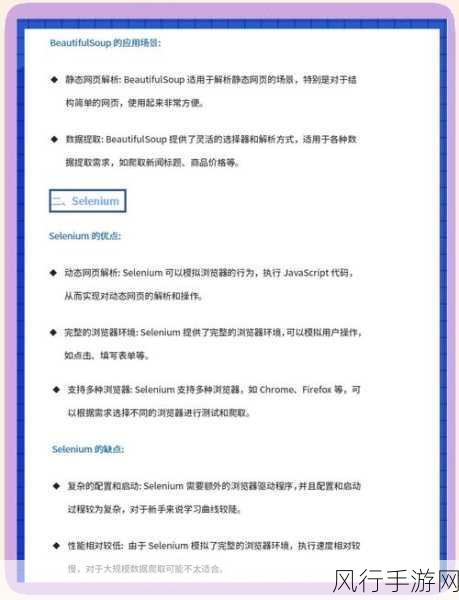

在数据采集阶段,要确保数据源的多样性和准确性,通过各种传感器、网络爬虫、业务系统等渠道获取的数据,可能存在格式不一致、缺失值、重复等问题,需要进行有效的数据清洗和预处理,以提高数据质量。

存储是大数据处理的重要环节,传统的关系型数据库在面对海量数据时往往显得力不从心,而分布式存储系统如 Hadoop 的 HDFS、NoSQL 数据库等则能够更好地应对大规模数据的存储需求,这些技术可以实现数据的分布式存储和并行处理,提高存储和访问的效率。

数据处理的核心在于算法和模型的选择,对于大规模数据的分析,常用的技术包括 MapReduce 编程模型、Spark 计算框架等,这些技术能够在大规模集群上实现高效的并行计算,快速处理海量数据,机器学习和深度学习算法也在大数据分析中发挥着重要作用,通过对数据的挖掘和预测,为企业提供有价值的决策支持。

优化服务器端的性能也是提高大数据处理效率的关键,合理配置服务器的硬件资源,如内存、CPU、网络带宽等,能够确保系统在处理大数据时的稳定性和高效性,采用数据压缩、索引优化、缓存等技术手段,可以减少数据的传输量和查询时间,提升系统的响应速度。

数据安全同样不容忽视,在处理海量数据时,要采取严格的加密、访问控制、数据备份等措施,保障数据的安全性和完整性。

高效应对服务器端的海量数据挑战需要从多个方面入手,包括数据采集和预处理、存储技术的选择、算法和模型的优化、服务器性能的提升以及数据安全的保障,只有综合运用这些策略和技术,才能在大数据时代中从容应对海量数据的冲击,挖掘出数据背后的巨大价值,为企业的发展和创新提供有力支持。

在未来,随着技术的不断进步和创新,相信我们会看到更多更先进的大数据处理技术和解决方案的出现,进一步推动大数据产业的发展和应用。