在当今数字化的时代,数据的获取变得愈发重要,Python3 爬虫技术成为了许多开发者和数据分析师的得力工具,在使用爬虫获取数据的过程中,IP 封禁是一个常见且令人头疼的问题,若不妥善处理,可能会导致爬虫工作的中断甚至法律风险,如何有效地避免 IP 被封禁呢?

要解决这个问题,我们需要先了解 IP 被封禁的原因,网站会对频繁且异常的访问请求进行监测和限制,如果爬虫在短时间内发送大量请求,或者请求的模式与正常用户行为差异过大,就很容易被网站的防护机制识别并封禁 IP。

我们可以采取多种策略来避免 IP 被封禁。

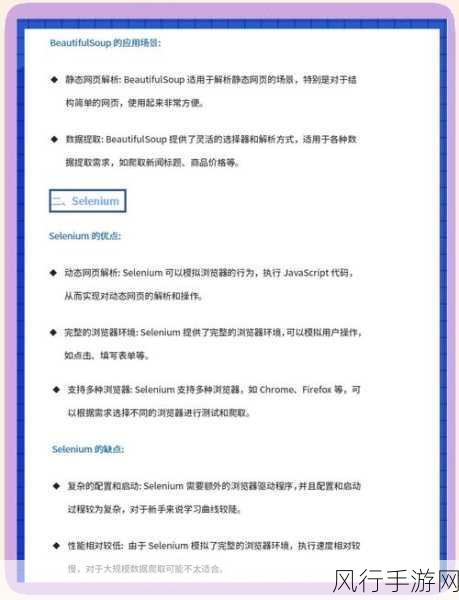

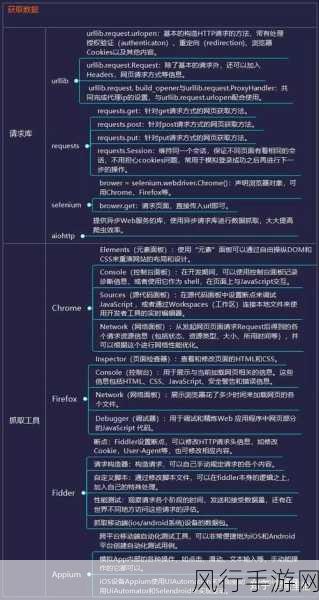

一种有效的方法是设置合理的请求间隔,模拟人类正常的访问频率,避免过于频繁地向目标网站发送请求,可以在每次请求之间添加随机的时间间隔,使爬虫的行为更接近真实用户。

使用代理 IP 也是常见的解决方案,通过获取大量有效的代理 IP 地址,并在爬虫程序中动态切换使用,能够有效降低单个 IP 发送请求的频率,从而减少被封禁的风险,但需要注意的是,选择可靠的代理服务提供商至关重要,以确保代理 IP 的质量和稳定性。

要遵循网站的规则和条款,有些网站明确禁止爬虫行为,或者对爬虫的访问频率和方式有特定的限制,在进行爬虫开发之前,务必仔细阅读并遵守相关规定,以免造成不必要的麻烦。

优化爬虫的请求头信息也是关键的一步,设置合理的 User-Agent、Referer 等参数,使请求看起来更像是来自正常的浏览器访问。

对于大规模的爬虫任务,可以考虑分布式爬虫架构,将爬虫任务分布到多个节点上,不仅可以提高数据获取的效率,还能降低单个 IP 被封禁的影响。

避免 Python3 爬虫的 IP 被封禁需要综合运用多种策略,并不断根据实际情况进行调整和优化,只有在合法、合规、合理的前提下,才能充分发挥爬虫技术的优势,获取到有价值的数据,在探索数据的道路上,我们既要追求高效,也要坚守道德和法律的底线,让技术为我们的生活和工作带来更多的便利和价值。