Kafka 作为一种高吞吐量的分布式消息队列系统,在大数据处理和实时数据传输中发挥着重要作用,当面临高峰流量时,如何确保 Kafka 的批量发送能够稳定高效地运行,成为了许多开发者和运维人员关注的焦点。

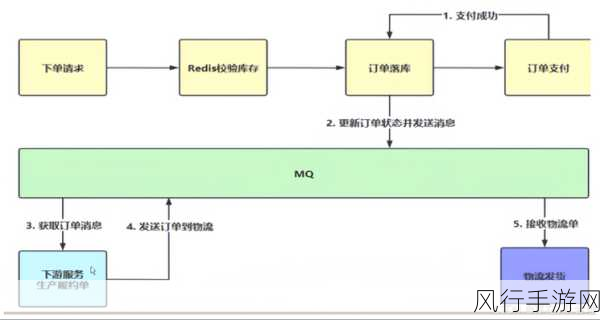

在实际应用场景中,业务的高峰时段可能会带来巨大的数据发送压力,比如电商平台的促销活动、金融系统的交易高峰等,这些情况下,数据量会瞬间激增,如果处理不当,可能会导致消息积压、延迟甚至系统崩溃。

要有效地应对 Kafka 批量发送的高峰,我们需要从多个方面进行考虑和优化。

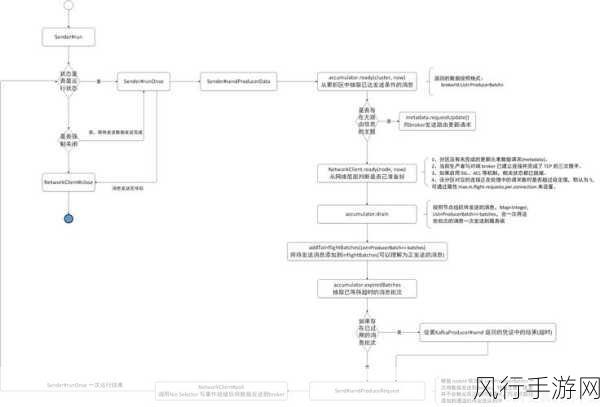

优化生产者配置是关键的一步,调整缓冲区大小、批量发送的大小和间隔等参数,可以显著提升发送效率,较大的缓冲区能够容纳更多待发送的消息,合适的批量大小和间隔则能在保证性能的同时,避免过度的资源消耗。

合理的分区策略至关重要,根据业务特点和数据分布,将主题划分为多个分区,能够实现并行发送,提高系统的并发处理能力,确保分区的负载均衡,避免某些分区过度繁忙而其他分区闲置。

监控和预警机制不可或缺,实时监控生产者和消费者的各项指标,如发送速率、积压数量、延迟时间等,一旦指标超过预设的阈值,及时发出警报,以便运维人员能够迅速采取措施进行干预。

考虑使用异步发送模式也是一个不错的选择,异步发送能够将发送操作与业务逻辑分离,减少发送过程中的阻塞,提高系统的整体响应性能,但需要注意处理好异步发送可能带来的消息丢失风险,通过适当的重试机制和错误处理来保障数据的可靠性。

还可以对 Kafka 集群进行横向扩展,增加 Broker 节点数量,提升集群的处理能力和存储容量,以应对不断增长的业务需求。

对业务代码进行优化也是不能忽视的环节,减少不必要的消息生成和发送,优化数据结构和算法,提高消息处理的效率。

应对 Kafka 批量发送的高峰需要综合运用多种技术手段和策略,从生产者配置、分区策略、监控预警、发送模式、集群扩展以及业务代码优化等方面入手,不断进行调整和优化,以保障系统在高峰时段的稳定运行和高效处理能力,只有这样,才能充分发挥 Kafka 的优势,为业务的发展提供坚实的支撑。