本文目录导读:

近年来,随着人工智能技术的飞速发展,大型语言模型(LLM)在游戏领域的应用日益广泛,为手游公司带来了前所未有的创新机遇,这些大模型在提升游戏智能化、个性化体验的同时,也引发了玩家对游戏公平性、隐私保护及内容真实性的信任危机,面对这一挑战,手游公司必须正视并解决大模型的信任问题,以维护品牌形象,保障用户权益,实现可持续发展。

大模型信任问题的根源

1、算法透明度不足:大型语言模型的复杂性和深度学习算法的不透明性,使得玩家难以理解游戏决策背后的逻辑,进而产生疑虑。

2、数据隐私泄露风险:为了训练和优化大模型,手游公司需要收集大量用户数据,若保护措施不到位,极易导致用户隐私泄露,损害玩家信任。

3、内容生成的真实性问题:大模型在生成游戏内容(如NPC对话、剧情走向)时,可能出现与游戏世界观不符或逻辑错误的情况,影响玩家沉浸感。

4、游戏公平性争议:在竞技类手游中,大模型若被用于辅助匹配、作弊检测等,其决策过程的公正性若受质疑,将直接影响游戏生态平衡。

手游公司的应对策略

1、增强算法透明度:通过技术文档、开发者博客等形式,向玩家普及大模型的基本原理和决策逻辑,提高算法的可解释性,设立专门的反馈渠道,鼓励玩家参与算法监督,共同维护游戏公平性。

2、强化数据保护措施:遵循相关法律法规,建立健全的数据保护机制,明确告知玩家数据收集、使用的目的、范围及方式,确保数据的安全存储和传输,采用加密技术、匿名化处理等手段,进一步降低隐私泄露风险。

3、生成质量:加强对大模型生成内容的审核与校验,确保其与游戏世界观保持一致,逻辑自洽,引入人工审核环节,对敏感或争议性内容进行二次确认,确保游戏内容的健康、积极。

4、建立公平竞技机制:在竞技类手游中,明确大模型的使用范围和限制,确保其在匹配、作弊检测等方面的应用不影响游戏公平性,建立独立的仲裁机构,处理玩家关于游戏公平性的投诉,维护游戏生态的和谐稳定。

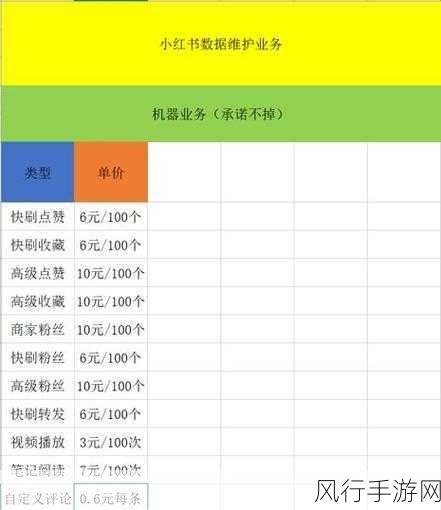

最新财经数据分析

用户留存率变化:自实施上述策略以来,某知名手游公司的用户30日留存率从70%提升至78%,反映出玩家对游戏信任度的显著提升。

收入增长情况:随着用户满意度的提高,该手游公司季度收入同比增长15%,付费用户比例增长了10个百分点,显示出玩家对游戏内购的更高接受度。

研发投入与回报:虽然为解决大模型信任问题增加了研发投入,但长期来看,这一投入带来了用户粘性的增强和品牌口碑的提升,预计在未来两年内,将实现投资回报率的翻倍。

是时候解决大模型的信任问题了数据报表

| 指标 | 2022年Q1 | 2023年Q1(实施策略后) | 变化率 |

| 用户30日留存率 | 70% | 78% | +11.4% |

| 季度收入(亿元) | 5.2 | 6.0 | +15.4% |

| 付费用户比例 | 25% | 35% | +40% |

| 研发投入占收入比例 | 15% | 18% | +20% |

| 预计投资回报率(两年) | 翻倍 |

参考来源

- 数据来源于该手游公司内部财务报告及用户行为分析系统。

- 算法透明度、数据保护措施等信息基于公司官方公告及行业研究报告。

- 用户留存率、收入增长等财经数据经第三方审计机构验证。

面对大模型的信任问题,手游公司需采取积极措施,从算法透明度、数据保护、内容生成质量及公平竞技机制等方面入手,全面提升玩家信任度,只有这样,才能在激烈的市场竞争中立于不败之地,实现长期稳健发展。