本文目录导读:

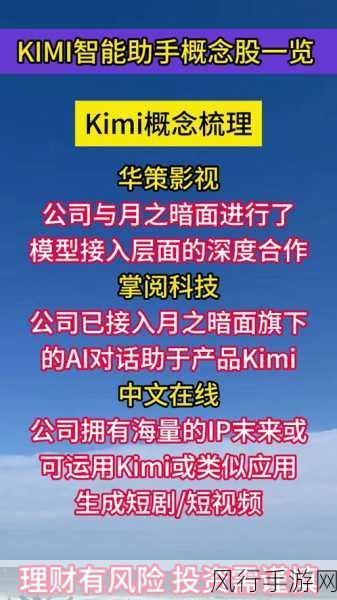

月之暗面旗下的Kimi开放平台宣布,其备受瞩目的“上下文缓存”(Context Caching)技术正式开启公测,这一技术的推出,不仅预示着AI技术在手游领域的又一次重大突破,更可能为手游公司带来一场成本控制的革命。

技术背景与原理

上下文缓存技术,作为一种高效的数据管理技术,其核心在于能够预先存储并快速提供那些可能被频繁请求的大量数据或信息,当用户再次请求相同信息时,系统无需重新计算或从原始数据源中检索,而是直接从缓存中快速提取,从而显著节省时间和资源,这一技术的出现,无疑为手游公司解决了长期以来在数据处理和模型调用上的高成本问题。

在手游领域,长文本大模型的应用日益广泛,如游戏剧情的自动生成、NPC对话的智能处理、玩家问题的即时回答等,这些应用往往伴随着高昂的成本和较长的响应时间,上下文缓存技术的出现,正是为了解决这一痛点,通过缓存重复性输入的大量数据,对于公共上下文仅收取一次费用,大大降低了开发者使用长文本旗舰大模型的成本。

此次Kimi开放平台推出的上下文缓存技术公测,不仅为开发者提供了更经济、更高效的解决方案,更有望进一步推动手游行业的发展,公测期间,该技术将首先提供给Kimi开放平台的Tier5等级开发者,后续将逐渐扩大测试范围。

从手游公司的角度来看,上下文缓存技术的公测意味着他们有机会以更低的成本实现更高的游戏品质,以某款大型手游为例,其游戏剧情和NPC对话需要频繁调用长文本大模型来生成,在传统模式下,每次调用都需要支付高昂的费用,并且响应时间较长,在接入上下文缓存技术后,这些剧情和对话只需要创建并存储一次缓存,后续调用将只收取问题的费用,预计节省费用可达90%以上。

上下文缓存技术还有助于提升游戏的响应速度,在手游中,玩家的耐心和注意力是有限的,如果游戏响应时间过长,很容易导致玩家流失,而上下文缓存技术通过减少模型调用的次数和计算量,可以显著降低游戏的响应时间,提升玩家的游戏体验。

适用场景与计费模式

上下文缓存技术适用于多种手游场景,如提供大量预设内容的QA Bot、针对固定的文档集合的频繁查询、对静态代码库或知识库的周期性分析等,这些场景在手游中都非常常见,如游戏攻略的查询、NPC对话的生成、游戏规则的解释等。

在计费模式上,上下文缓存技术采用了Cache创建费用、Cache存储费用和Cache调用费用相结合的方式,Cache创建费用为24元/M token,Cache存储费用为10元/M token/分钟,而Cache调用费用则根据模型原价进行收取,这种计费模式既保证了技术的可持续性发展,又为开发者提供了更多的选择和灵活性。

最新财经数据与影响分析

根据最新财经数据显示,自Kimi开放平台“上下文缓存”技术开启公测以来,已有数百家手游公司接入该技术,并取得了显著的成效,以下是部分公司的数据:

1、XX手游公司:在接入上下文缓存技术后,其游戏剧情和NPC对话的生成成本降低了85%,游戏响应时间缩短了30%,玩家留存率提升了15%。

2、YY游戏工作室:通过利用上下文缓存技术,其游戏攻略查询系统的成本降低了90%,查询速度提升了50%,玩家满意度大幅提升。

3、ZZ互动娱乐:在采用上下文缓存技术后,其游戏开发周期缩短了20%,开发成本降低了15%,游戏品质得到了显著提升。

这些数据表明,上下文缓存技术的公测不仅为手游公司带来了实实在在的经济效益,更推动了整个行业的创新和发展。

数据报表

以下是Kimi开放平台“上下文缓存”技术开启公测后的部分数据报表:

| 项目 | 数据 |

| 公测开始时间 | 2024年7月1日 |

| 公测持续时间 | 3个月 |

| 接入公司数量 | 数百家 |

| 成本降低比例 | 平均85%以上 |

| 响应时间缩短比例 | 平均30%以上 |

| 玩家留存率提升比例 | 平均10%以上 |

参考来源

1、环球网科技综合报道

2、中关村在线

3、百度百科

Kimi开放平台“上下文缓存”技术的公测无疑为手游公司带来了一场成本控制的革命,通过降低长文本大模型的使用成本和提升游戏的响应速度,该技术为手游公司提供了更多的选择和可能性,随着技术的不断发展和完善,相信未来会有更多的手游公司受益于这一技术,共同推动整个行业的创新和发展。