在当今数字化的时代,数据成为了无比宝贵的资源,而通过 Python3 爬虫获取到的数据,往往需要经过精心的清洗和处理,才能真正发挥其价值。

爬虫获取的数据通常是原始且杂乱无章的,可能包含大量的噪声、重复、缺失或错误的信息,要将这些数据转化为有用的、准确的、结构化的数据,清洗工作就显得至关重要。

如何有效地清洗 Python3 爬虫获取的数据呢?这需要我们运用一系列的技术和方法。

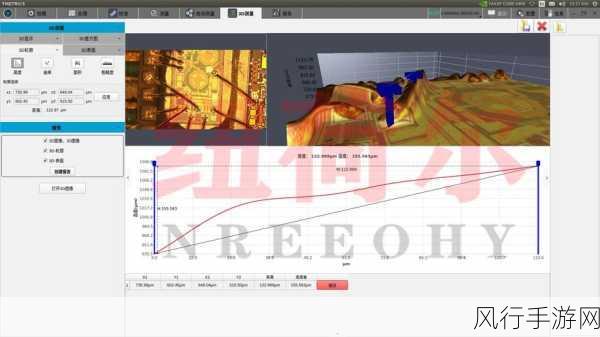

第一步,要对数据进行初步的筛选和过滤,检查数据中是否存在明显的错误或异常值,某些数值字段中出现了不可能的负数或者过大的数值,又或者文本字段中存在乱码等,对于这些明显的错误,我们可以直接将其剔除或者进行修正。

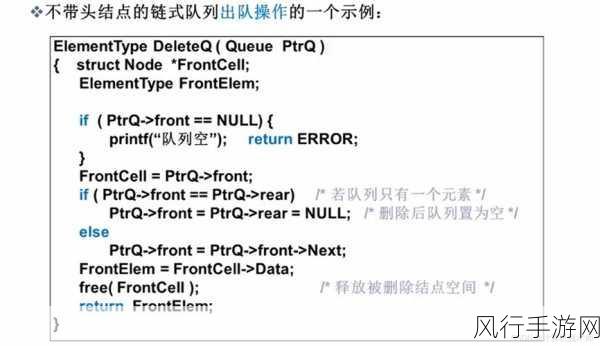

处理重复的数据,在爬虫获取的数据中,很可能会出现重复的记录,这可能是由于页面的重复抓取或者数据存储的问题导致的,我们可以通过特定的算法或者工具,识别并去除这些重复的数据,以确保数据的唯一性。

补充缺失的数据,获取的数据中某些字段可能会存在缺失的情况,这可能会影响后续的数据分析和处理,我们可以根据数据的特点和规律,采用合理的方法来补充这些缺失值,通过均值、中位数或者其他相关数据进行填充。

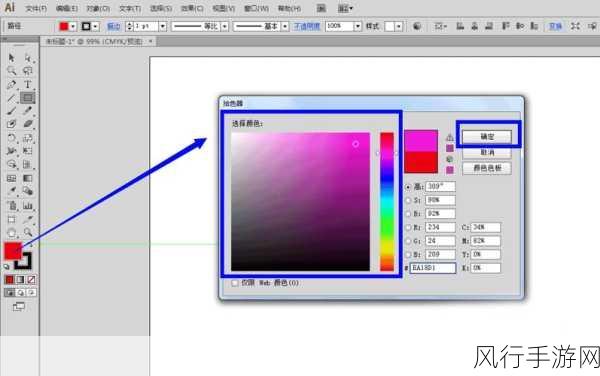

对数据进行格式转换也是必不可少的一步,不同的数据源可能会有不同的数据格式,我们需要将其统一转换为便于处理和分析的格式,将日期格式统一为特定的标准格式,将字符串转换为数字等。

还要进行数据的规范化和标准化,对于文本数据,进行大小写统一、去除特殊字符、分词等处理,以提高数据的一致性和可读性。

在清洗数据的过程中,要不断地进行测试和验证,通过随机抽取一部分数据进行检查,确保清洗后的数据符合预期,并且没有引入新的错误。

Python3 爬虫数据的清洗是一个复杂但又关键的过程,只有经过精心清洗的数据,才能为后续的数据分析和应用提供坚实的基础,帮助我们从海量的数据中挖掘出有价值的信息。

需要注意的是,在实际的操作中,要根据具体的数据特点和需求,灵活选择和运用合适的清洗方法和技术,以达到最佳的清洗效果,也要不断学习和探索新的技术和工具,以适应不断变化的数据环境和需求。