深入探究 Spark 函数中的数据同步之道

在当今大数据处理的领域中,Spark 作为一款强大的分布式计算框架,被广泛应用于各种数据处理场景,而在实际应用中,如何有效地进行数据同步是一个至关重要的问题。

Spark 函数的数据同步并非一项简单的任务,它涉及到多个方面的知识和技术,要理解 Spark 函数中的数据同步,我们需要先明确数据同步的概念和目的。

数据同步的核心目标是确保在分布式环境下,不同节点之间的数据能够保持一致性和准确性,在 Spark 中,这意味着当数据在不同的执行器节点上进行处理和计算时,需要有一种机制来协调和同步这些数据,以避免出现数据不一致或者错误的计算结果。

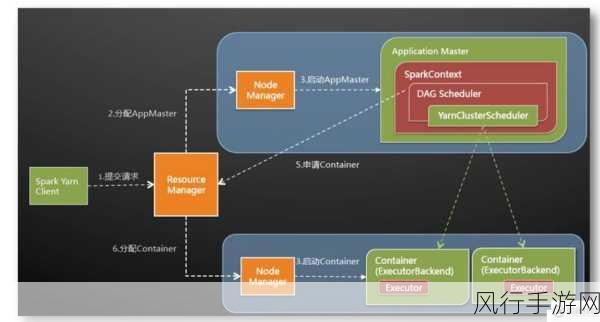

Spark 函数是如何实现数据同步的呢?Spark 利用了其强大的分布式存储和计算能力,通过将数据分布在多个节点上进行并行处理,提高了数据处理的效率,为了保证数据的同步,Spark 采用了一些关键的技术和策略。

广播变量(Broadcast Variables)是一种常用的数据同步方式,广播变量可以将一个只读的变量在集群中的各个节点上进行广播,使得每个节点都能够获取到相同的变量值,从而避免了在每个任务中重复传输相同的数据,减少了网络开销。

累加器(Accumulators)也是 Spark 中用于数据同步的重要工具,累加器可以用于对某个值进行累加操作,并且在不同的任务之间进行同步和汇总,从而方便地统计和监控一些关键指标。

除此之外,Spark 还通过数据分区(Data Partitioning)和数据缓存(Data Caching)等技术来优化数据同步的性能,合理的数据分区可以将数据均匀地分布在不同的节点上,减少数据倾斜和计算不平衡的问题,而数据缓存则可以将经常使用的数据缓存在内存中,提高数据的访问速度和计算效率。

在实际应用中,要根据具体的业务需求和数据特点,选择合适的数据同步方式和技术,还需要对 Spark 的配置参数进行优化,以充分发挥其性能优势。

Spark 函数中的数据同步是一个复杂而又关键的问题,通过深入理解 Spark 的相关技术和原理,并结合实际应用场景进行优化和调整,我们能够更好地利用 Spark 来处理大规模的数据,实现高效、准确的数据处理和分析。