在当今数字化信息时代,数据的价值日益凸显,而爬虫技术成为了获取数据的重要手段之一,Python 多线程爬虫因其高效性而备受青睐,但在实际应用中,异常处理是一个不可忽视的关键环节。

当我们运用 Python 多线程爬虫时,可能会遇到各种各样的异常情况,这些异常可能源于网络连接的不稳定、目标网站的反爬虫机制、代码逻辑的错误等等,如果不能妥善处理这些异常,不仅会影响爬虫的效率和准确性,甚至可能导致程序崩溃或被目标网站封禁。

如何有效地处理 Python 多线程爬虫中的异常呢?

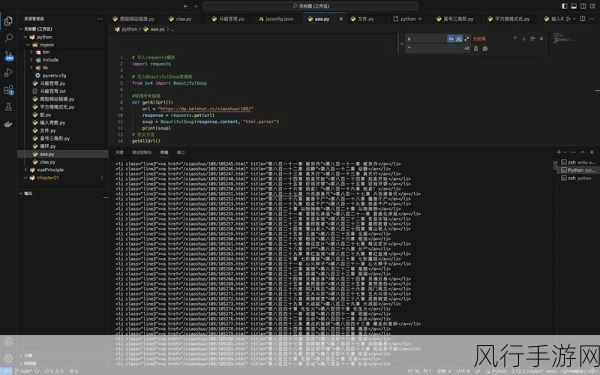

一种常见的方法是使用 try-except 语句块来捕获和处理异常,在多线程爬虫中,我们可以将每个线程执行的爬虫任务放在 try 语句块中,当出现异常时,就会跳转到对应的 except 语句块进行处理,如果遇到网络连接超时的异常,我们可以设置一个重试机制,在一定次数内重新尝试连接,以提高爬虫的稳定性。

我们还可以利用线程池的回调函数来处理异常,当线程执行完毕后,通过回调函数获取线程的执行结果,如果结果为异常对象,就可以进行相应的处理。

合理设置爬虫的请求间隔和并发数量也是避免异常的重要策略,过于频繁的请求和过高的并发可能会触发目标网站的反爬虫机制,导致异常的发生,需要根据目标网站的特点和自身的需求,找到一个合适的平衡点。

为了更好地跟踪和分析异常情况,我们应该建立完善的日志系统,将异常的相关信息,如异常类型、发生时间、错误信息等详细记录下来,以便后续进行问题排查和优化。

处理 Python 多线程爬虫中的异常需要综合运用多种技术和策略,从代码层面的异常捕获和处理,到合理的爬虫参数设置,再到完善的日志记录,每一个环节都至关重要,只有这样,我们才能打造出高效、稳定、可靠的多线程爬虫程序,为获取有价值的数据提供有力的支持。