在当今的机器学习领域,PyTorch 和 PyG(PyTorch Geometric)已经成为许多研究者和开发者构建复杂模型的有力工具,如何提高这些模型的解释性却成为了一个关键问题,模型解释性的重要性不言而喻,它能够帮助我们理解模型的决策过程,增强对模型的信任,并且在实际应用中更好地发现潜在的问题和改进方向。

要提升 PyTorch 和 PyG 模型的解释性,我们需要从多个方面入手,特征可视化是一种直观有效的方法,通过将模型学习到的特征以可视化的形式呈现出来,我们可以对模型的内部运作有一个初步的了解,对于图像数据,我们可以将卷积层提取的特征图进行可视化,观察模型关注的区域和特征模式。

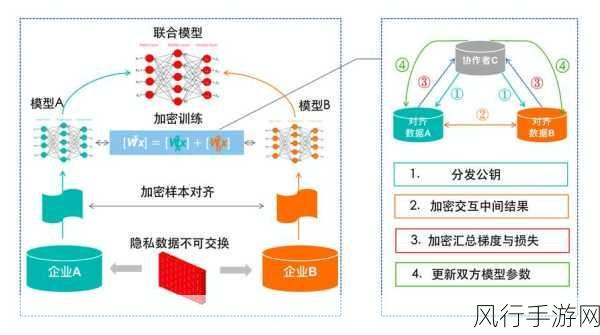

另一个重要的策略是使用解释性模型,一些专门设计的解释性模型,如 LIME(Local Interpretable Model-agnostic Explanations)和 SHAP(SHapley Additive exPlanations),可以为复杂模型的预测结果提供局部和全局的解释,这些模型通过分析输入特征对预测的贡献程度,帮助我们理解模型是如何做出决策的。

模型结构的简化和优化也有助于提高解释性,过于复杂的模型结构可能导致内部的计算过程难以理解,在设计模型时,可以考虑采用更简洁、更具可解释性的架构,或者对已有的复杂模型进行压缩和剪枝,去除冗余的部分。

我们还可以通过案例分析来深入理解模型的行为,选择具有代表性的样本数据,详细分析模型在这些数据上的预测结果和决策过程,从而发现模型的规律和特点。

在实际应用中,结合多种解释性方法往往能够取得更好的效果,将特征可视化与解释性模型相结合,或者对不同案例分析的结果进行综合比较,能够更全面、深入地揭示模型的工作机制。

提高 PyTorch 和 PyG 模型的解释性是一个综合性的任务,需要我们运用多种方法和策略,不断探索和实践,只有这样,我们才能更好地理解和利用这些强大的工具,为实际问题提供更可靠、更可解释的解决方案。