在 C 语言编程的世界里,delay 函数常常被用于实现时间的延迟,一个关键的问题摆在我们面前:delay 函数能否精确到毫秒级别呢?

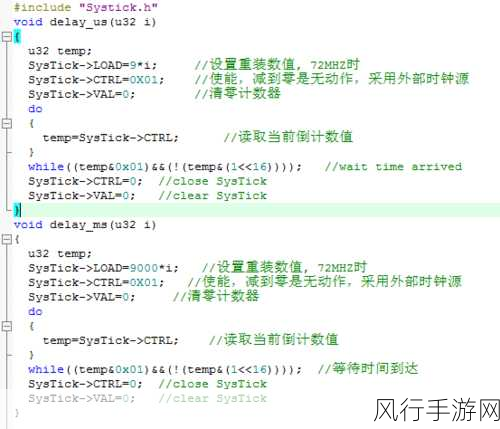

要深入探讨这个问题,我们需要先了解 delay 函数的工作原理,delay 函数是通过某种计时机制来实现延迟的,但不同的系统和编译器,其实现方式可能会有所差异。

在一些简单的嵌入式系统中,由于硬件资源的限制,delay 函数可能无法达到很高的精度,尤其是在精确到毫秒级别时,这是因为这些系统的时钟频率较低,计时精度有限。

而在较为复杂的操作系统环境下,Windows 或 Linux,虽然系统提供了更精确的时钟和计时功能,但 C 语言中的 delay 函数也未必能直接利用这些高精度的特性。

如何才能提高 delay 函数的精度呢?一种常见的方法是使用系统提供的高精度计时函数,并结合适当的算法来实现更精确的延迟,但这需要对系统的底层机制有深入的了解,并且编程实现起来可能会比较复杂。

还需要考虑到程序运行时的其他因素对 delay 精度的影响,系统的负载、其他进程的占用等都可能导致延迟的实际效果与预期有所偏差。

C 语言中的 delay 函数能否精确到毫秒级别并不是一个绝对的答案,它取决于多种因素,包括运行环境、系统资源、编程方法等,在实际编程中,我们需要根据具体的需求和情况,选择合适的方法来实现所需的时间延迟精度。

对于开发者来说,深入理解这些原理和机制,不断探索和尝试新的方法,才能在编程中更好地掌控时间,实现更加精确和可靠的程序功能,希望通过这篇文章,能让您对 C 语言中 delay 函数的毫秒精度问题有更清晰的认识和理解。