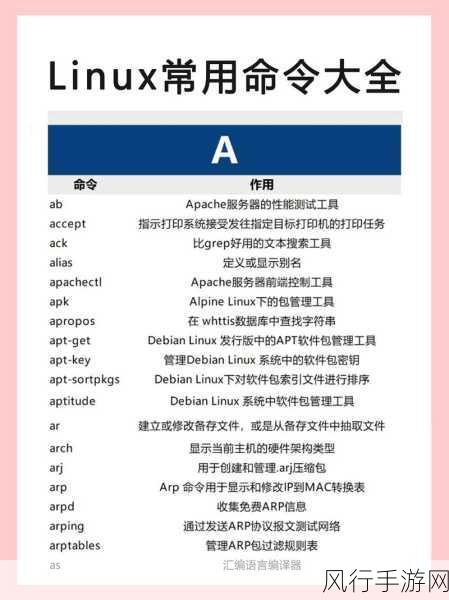

Linux 操作系统作为一款强大且广泛应用的系统,其丰富的命令行工具为用户提供了诸多高效处理数据的方法,去重命令在处理数据时经常会被用到。

在日常的工作和数据处理中,我们可能会遇到需要去除重复数据的情况,这时,选择合适的 Linux 去重命令就显得至关重要。

Linux 中常见的去重命令有uniq 和sort -u 。uniq 命令通常用于相邻的重复行的去除,它要求输入数据是已经排序好的,如果输入的数据没有排序,那么它可能无法达到预期的去重效果,而sort -u 则会先对输入的数据进行排序,然后去除重复的行。

当我们处理较小规模的数据时,uniq 可能是一个不错的选择,它的语法相对简单,使用起来较为便捷,但需要注意的是,使用uniq 之前,最好先对数据进行排序,以确保能够准确去除重复行。

对于大规模的数据处理,sort -u 可能表现得更加出色,它能够在排序的同时完成去重操作,尽管在处理过程中可能会消耗相对较多的系统资源,但对于大型数据集来说,其效率和准确性更有保障。

在实际应用中,还需要根据具体的需求和数据特点来选择合适的去重命令,如果数据本身已经是有序的,那么直接使用uniq 会更加高效;如果数据无序且规模较大,那么sort -u 则是更好的选择。

了解和熟练掌握 Linux 的去重命令,可以大大提高我们在数据处理方面的工作效率,为各种任务的顺利完成提供有力支持,无论是在系统管理、数据分析还是日常的文件处理中,正确选择和运用去重命令都能让我们事半功倍。