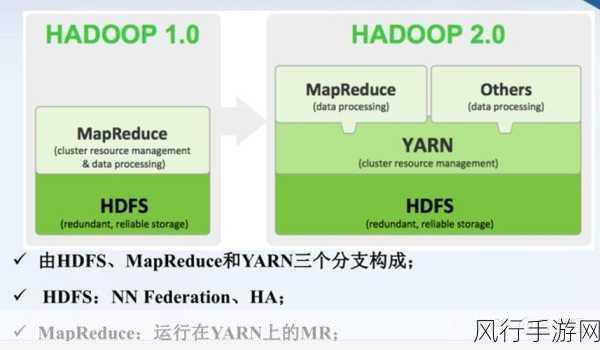

Hadoop 生态系统作为大数据处理领域的重要架构,其容错机制的有效性对于保障数据处理的准确性和稳定性至关重要,在处理海量数据的过程中,各种不可预见的故障随时可能发生,因此强大的容错能力是 Hadoop 生态系统持续稳定运行的关键。

容错机制的强化并非一蹴而就,它需要从多个层面进行深入的考量和优化,数据备份和恢复策略是容错机制的基础环节,Hadoop 采用分布式存储方式,将数据分散存储在多个节点上,为了应对节点故障导致的数据丢失,系统会自动对数据进行多副本备份,这样,即使某个节点出现故障,其他节点上的副本仍能保证数据的可用性。

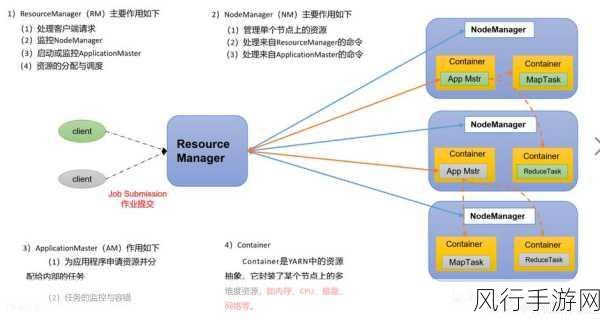

Hadoop 生态系统中的任务监控和恢复机制也发挥着重要作用,在任务执行过程中,系统会实时监控任务的状态,一旦发现某个任务出现故障或异常,会立即启动恢复机制,重新分配任务到其他健康的节点上继续执行,从而确保整个任务流程不受单点故障的影响。

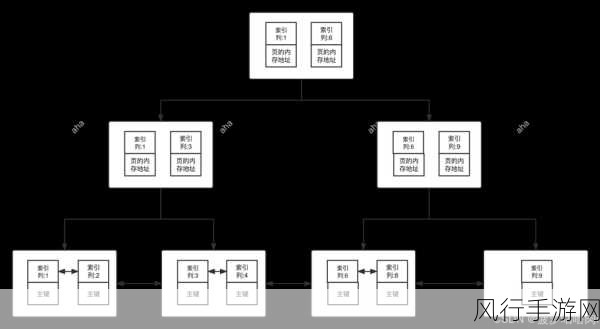

网络拓扑感知能力的提升也是增强容错机制的有效手段,Hadoop 能够了解整个集群的网络拓扑结构,在数据分配和任务调度时,充分考虑网络延迟和带宽等因素,尽量将相关任务和数据分配到网络距离较近的节点上,减少数据传输的开销和故障风险。

除此之外,Hadoop 还不断优化其错误检测和处理算法,通过更精确的错误检测手段,能够更早地发现潜在的问题,并采取相应的措施进行处理,而高效的错误处理算法则能够在问题发生时,快速定位故障点,采取最佳的解决方案,最大程度减少故障对系统整体性能的影响。

Hadoop 生态系统的容错机制是一个复杂而又不断发展的体系,通过持续的技术创新和优化,不断提升其容错能力,为大数据处理提供更加可靠和稳定的支撑,推动大数据技术在各个领域的广泛应用和深入发展。