深入探究 Hive 集群扩容的关键步骤与策略

Hive 集群在大数据处理中扮演着至关重要的角色,当数据量不断增长,业务需求日益复杂时,扩容 Hive 集群成为了保障系统性能和稳定性的关键举措。

要成功实现 Hive 集群的扩容,需要对多个方面进行深入的理解和精心的规划,硬件资源的评估是首要任务,这包括对服务器的 CPU 核心数、内存容量、存储容量和网络带宽等关键指标的考量,只有准确评估当前业务的负载情况以及未来的增长趋势,才能合理确定所需增加的硬件资源类型和数量。

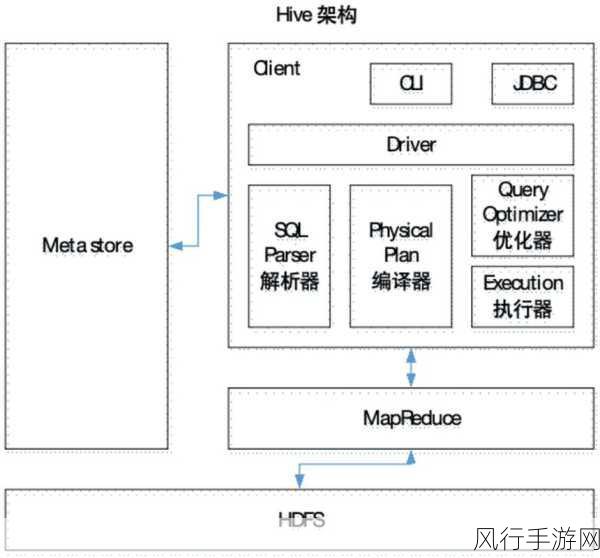

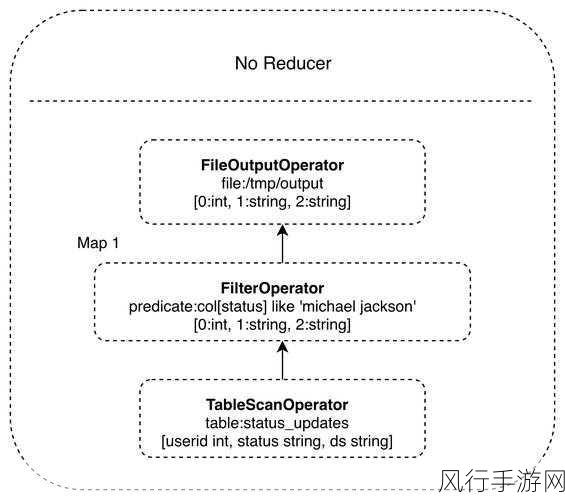

软件配置的优化同样不容忽视,调整 Hive 的参数设置,如并行度、内存分配等,可以显著提升系统的运行效率,确保 Hadoop 生态系统中其他相关组件的版本兼容性也是至关重要的,以免因版本不匹配导致扩容过程中出现意外问题。

在进行扩容操作时,数据迁移也是一个需要谨慎处理的环节,为了避免数据丢失或损坏,需要制定详细的数据迁移计划,并采用可靠的数据迁移工具和技术,对于大规模的数据迁移,还需要进行充分的测试和验证,以确保迁移过程的稳定性和数据的完整性。

新增节点的部署和配置也需要严格按照规范进行,包括操作系统的安装、Hadoop 相关组件的部署、网络配置等,在部署完成后,还需要进行全面的性能测试和压力测试,以验证扩容后的 Hive 集群是否能够满足预期的性能要求。

要注意扩容后的监控和维护,持续监控系统的性能指标,如 CPU 利用率、内存使用率、查询响应时间等,及时发现并解决可能出现的性能瓶颈和故障,定期对系统进行优化和调整,以适应不断变化的业务需求。

Hive 集群的扩容是一个复杂而系统的工程,需要综合考虑硬件、软件、数据迁移、节点部署和监控维护等多个方面,只有在各个环节都做到严谨细致,才能确保扩容工作的顺利完成,为大数据处理提供更强大的支撑。