探究 Hive Shuffle 在分布式环境下的卓越表现

在当今大数据处理的领域中,Hive Shuffle 扮演着至关重要的角色,它对于分布式计算环境中的数据处理和任务分配有着深远的影响。

Hive Shuffle 是 Hive 数据处理框架中的一个关键环节,其主要作用在于对数据进行重新分布和排序,以便后续的计算操作能够更高效地进行,在分布式环境下,由于数据量庞大且分布在不同的节点上,Hive Shuffle 的表现直接决定了整个任务的执行效率和资源利用情况。

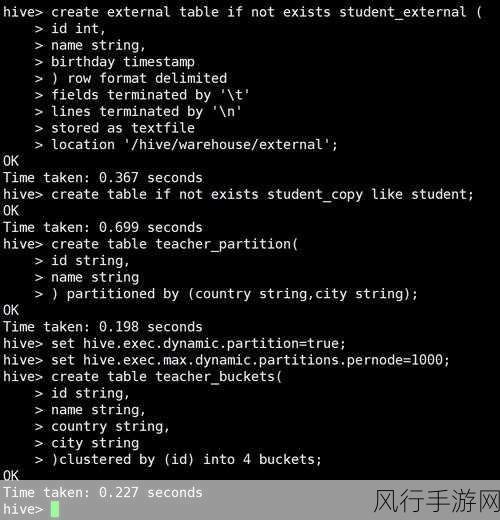

Hive Shuffle 的工作原理是通过对输入数据进行特定的分区和排序,将具有相同键值的数据分配到相同的分区中,这样,在后续的处理阶段,相同分区的数据可以在同一节点上进行处理,减少了数据在网络中的传输和节点之间的通信开销。

在实际应用中,Hive Shuffle 的性能优化是一个重要的课题,合理地设置分区数量和分区键可以有效地提高 Shuffle 的效率,分区数量过多可能导致资源的过度消耗和任务的调度复杂性增加;分区数量过少则可能无法充分发挥分布式计算的优势,对数据的压缩和缓存策略也能够显著提升 Hive Shuffle 的性能,通过对数据进行压缩,可以减少数据的存储空间和网络传输量;而合理的缓存策略则可以避免重复计算和数据的重复读取。

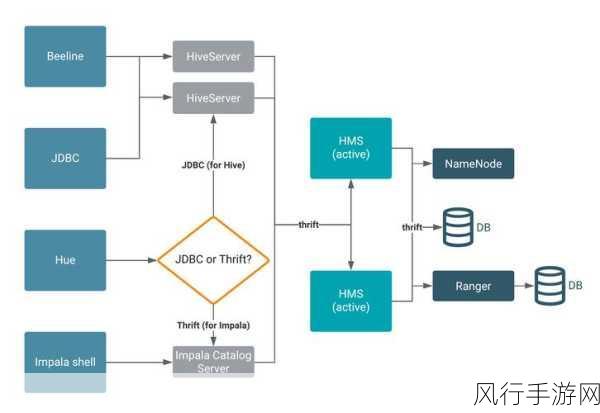

Hive Shuffle 还需要与其他组件和技术进行协同工作,以实现更优的性能,与 Hadoop 的分布式文件系统(HDFS)结合,确保数据的可靠存储和高效读取;与 YARN 资源管理器配合,实现资源的合理分配和任务的调度。

Hive Shuffle 在分布式环境中的表现对于大数据处理的性能和效率具有决定性的作用,深入理解和优化 Hive Shuffle 的工作机制和性能,对于提升大数据处理的能力和应用效果具有重要的意义,随着技术的不断发展和应用场景的日益复杂,对于 Hive Shuffle 的研究和创新也将持续进行,为大数据处理带来更高效、更可靠的解决方案。