Python 爬虫中 POST 请求的封禁风险剖析

在当今数字化信息时代,Python 爬虫作为一种获取数据的有效手段,被广泛应用于各个领域,当涉及到使用 POST 请求时,许多开发者和数据采集者心中都会产生一个疑问:Python 爬虫的 POST 请求会遭遇封禁吗?

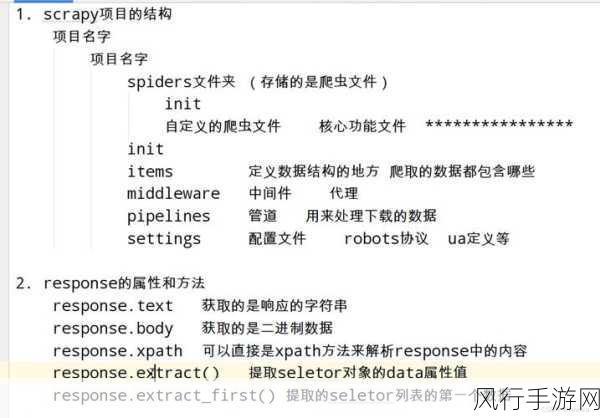

要回答这个问题,我们需要先了解什么是 POST 请求以及网站对于爬虫的封禁机制,POST 请求是 HTTP 协议中的一种请求方法,常用于向服务器提交数据,例如表单提交、文件上传等,而网站为了保护自身的资源和服务质量,通常会采取一系列措施来防范爬虫的过度访问。

网站封禁爬虫的原因多种多样,大量频繁的爬虫请求可能会给服务器带来巨大的负载压力,影响正常用户的访问体验;某些爬虫可能会获取未经授权的数据,侵犯网站的权益或者违反相关法律法规。

具体到 Python 爬虫的 POST 请求,其是否会被封禁取决于多个因素,首先是请求的频率和强度,如果在短时间内发送大量的 POST 请求,很容易引起网站的警觉并触发封禁机制,其次是请求的目标和内容,如果目标网站明确禁止爬虫访问,或者爬虫所提交的数据存在异常或违规,也可能导致被封禁。

为了降低 Python 爬虫 POST 请求被封禁的风险,开发者需要遵循一些原则和最佳实践,要合理控制请求的频率,模拟人类正常的访问行为,可以设置适当的间隔时间,避免过于密集的请求,要尊重网站的规则和服务条款,不试图获取禁止访问的数据。

还可以通过使用代理 IP 来分散请求的来源,降低被封禁的风险,但需要注意的是,使用代理 IP 也要遵循合法合规的原则。

Python 爬虫的 POST 请求并非一定会遭遇封禁,但需要开发者谨慎使用,遵循相关规则和道德准则,以确保数据采集的合法性和可持续性,只有在合法合规的前提下,充分发挥 Python 爬虫的优势,才能为我们的工作和研究带来更多有价值的信息。

在实际应用中,开发者应该不断总结经验,根据不同网站的特点和要求,灵活调整爬虫策略,以实现高效、稳定且合法的数据采集,也要关注技术的发展和法律的变化,及时更新自己的知识和方法,确保始终走在正确的道路上。

希望通过以上的分析,能让大家对 Python 爬虫中 POST 请求的封禁风险有一个更清晰的认识,从而在进行相关开发和应用时能够更加得心应手。