探索网页爬虫代码的 Python 编写之道

在当今数字化的时代,数据的获取和处理变得至关重要,网页爬虫作为一种有效的数据收集手段,能够帮助我们从海量的网络信息中提取有价值的数据,Python 作为一种功能强大且简单易学的编程语言,为编写网页爬虫提供了便利。

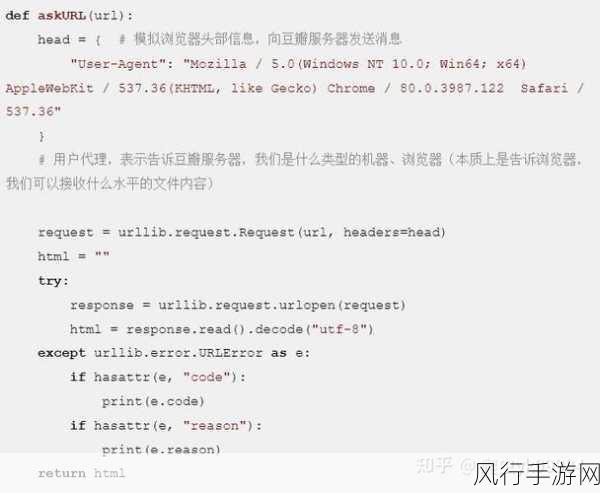

网页爬虫的核心在于模拟浏览器的行为,自动访问网页并提取所需的信息,要实现这一目标,我们需要运用 Python 的相关库和技术。

第一步,我们需要明确要爬取的目标网页和所需提取的数据,这就像是在茫茫大海中确定我们要寻找的宝藏位置,如果我们想要获取某个新闻网站的最新文章标题和内容,那么我们就需要先分析该网站的页面结构,找到包含文章标题和内容的特定元素。

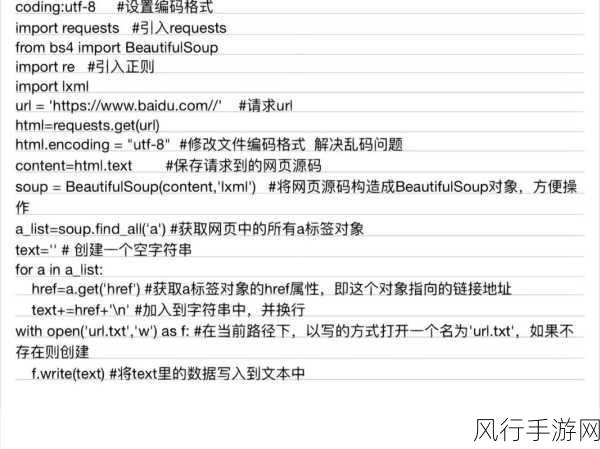

我们要安装必要的 Python 库,比如requests 用于发送 HTTP 请求获取网页内容,BeautifulSoup 用于解析网页,安装完成后,就可以开始编写代码了。

使用requests 库发送 GET 请求获取网页的 HTML 代码,代码可能如下所示:

import requests

response = requests.get('目标网页的 URL')

html_content = response.text使用BeautifulSoup 库对获取到的 HTML 内容进行解析,如果我们想要提取所有的新闻标题,可以这样写:

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'html.parser')

titles = soup.find_all('h2', class_='news-title')

for title in titles:

print(title.text)在编写网页爬虫代码时,还需要注意一些法律和道德规范,不要过度频繁地访问网站,以免对网站的正常运行造成影响,同时也要遵守网站的使用条款和隐私政策。

还需要处理一些可能出现的异常情况,比如网络连接错误、网页解析错误等,通过添加适当的错误处理代码,可以让我们的爬虫更加健壮和可靠。

编写网页爬虫代码需要综合考虑目标网页的结构、所需提取的数据、使用的库和工具,以及法律和道德规范等多个方面,通过不断的实践和学习,我们能够用 Python 编写出高效、准确的网页爬虫,为我们的数据处理和分析工作提供有力的支持。