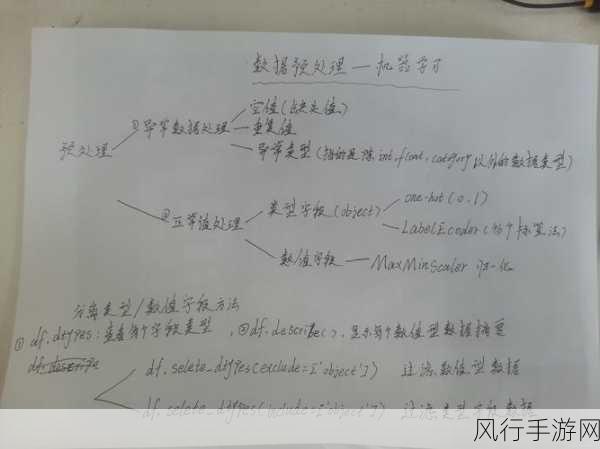

在当今数据驱动的时代,数据预处理成为了数据分析和机器学习中至关重要的环节,而其中的归一化操作,更是能够为后续的分析和模型训练提供有力支持。

归一化是一种将数据转换到特定范围内的处理方法,其主要目的是消除不同特征之间的量纲差异,使得数据具有可比性。

要进行 Python 中的数据归一化,我们可以采用多种方法,其中较为常见的是最小-最大归一化(Min-Max Normalization),这种方法将数据线性地映射到指定的区间,通常是[0, 1],实现这一方法的代码相对简单,假设我们有一组数据data = [10, 20, 30, 40, 50] ,我们可以通过以下代码进行最小-最大归一化:

import numpy as np

def min_max_normalization(data):

min_val = np.min(data)

max_val = np.max(data)

return [(x - min_val) / (max_val - min_val) for x in data]

data = [10, 20, 30, 40, 50]

normalized_data = min_max_normalization(data)

print(normalized_data)另一种常用的归一化方法是 Z-Score 标准化(Z-Score Normalization),它通过将数据减去均值并除以标准差,将数据转换为具有零均值和单位标准差的分布,以下是使用 Python 实现 Z-Score 标准化的示例代码:

import numpy as np

def z_score_normalization(data):

mean = np.mean(data)

std = np.std(data)

return [(x - mean) / std for x in data]

data = [10, 20, 30, 40, 50]

normalized_data = z_score_normalization(data)

print(normalized_data)在实际应用中,选择哪种归一化方法取决于数据的特点和具体的分析需求,如果数据分布较为均匀,最小-最大归一化可能是一个不错的选择,而当数据存在异常值或者需要符合标准正态分布时,Z-Score 标准化则更为合适。

还需要注意的是,归一化应该在对数据有充分理解的基础上进行,某些情况下,某些特征可能并不适合进行归一化处理,或者需要先进行数据清洗和异常值处理等操作。

Python 为数据预处理中的归一化提供了强大而便捷的工具和方法,通过合理地选择和应用归一化技术,我们能够更好地准备数据,为后续的数据分析和机器学习任务打下坚实的基础。