在当今的人工智能领域,模型推理的效率成为了一个关键的考量因素,特别是在处理大规模数据和复杂模型结构时,如何加速模型推理以实现更快速的响应和更低的资源消耗至关重要,PyTorch 和 PyG(PyTorch Geometric)作为广泛应用的深度学习框架和图神经网络工具包,为解决这一问题提供了丰富的可能性。

模型推理速度的提升并非一蹴而就,它涉及到多个方面的优化和调整,从数据预处理到模型架构的设计,再到硬件的充分利用,每一个环节都可能对推理效率产生显著影响。

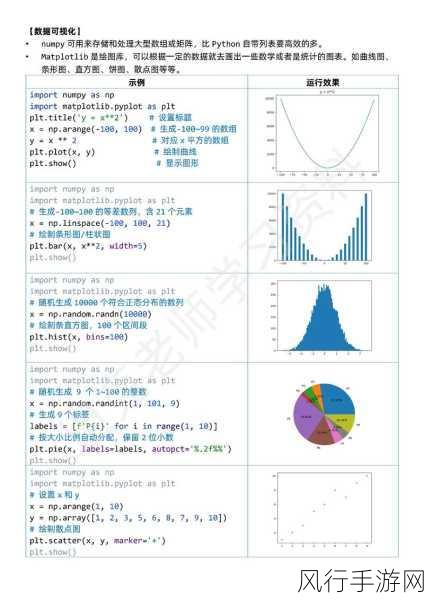

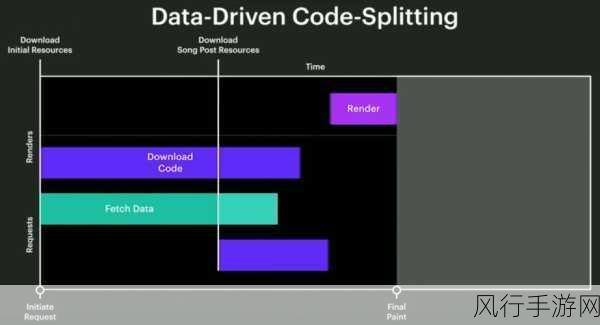

对于 PyTorch 和 PyG 数据的加载和预处理是影响推理速度的重要环节,合理地使用数据并行化技术,DataLoader 中的多线程加载和预处理,可以显著减少数据准备时间,对数据进行压缩、裁剪等操作,在不损失关键信息的前提下减小数据规模,也能够加快推理过程。

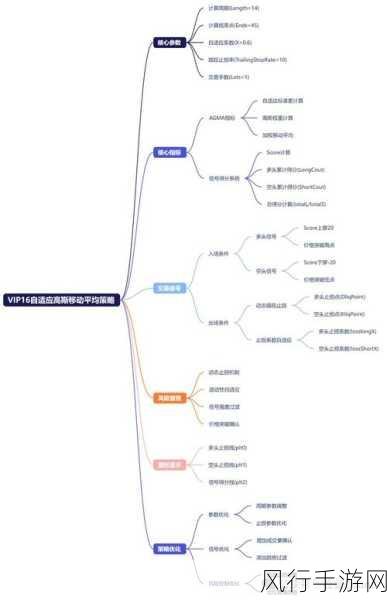

模型架构的优化同样关键,在 PyTorch 和 PyG 中,可以通过减少模型的参数数量、采用更高效的层结构(如深度可分离卷积)以及利用模型量化技术来降低计算复杂度,剪枝技术可以去除模型中不重要的连接和参数,从而减少计算量,提高推理速度。

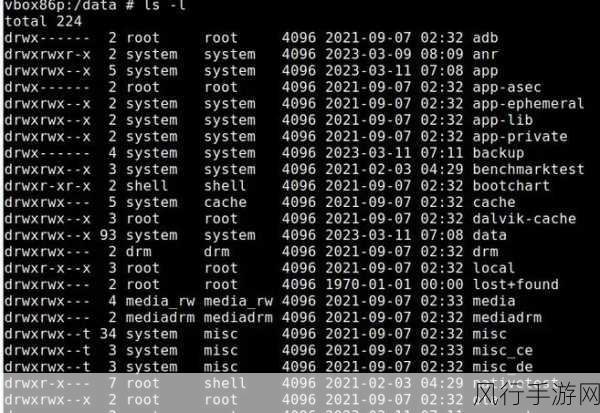

硬件加速也是提升推理效率的重要手段,利用 GPU 进行并行计算是常见的做法,通过合理设置 CUDA 环境、优化内存分配和使用 CUDA 内核融合等技术,可以充分发挥 GPU 的性能,对于一些特定的场景,如边缘设备上的推理,可以考虑使用专用的硬件加速模块,如 TPU 等。

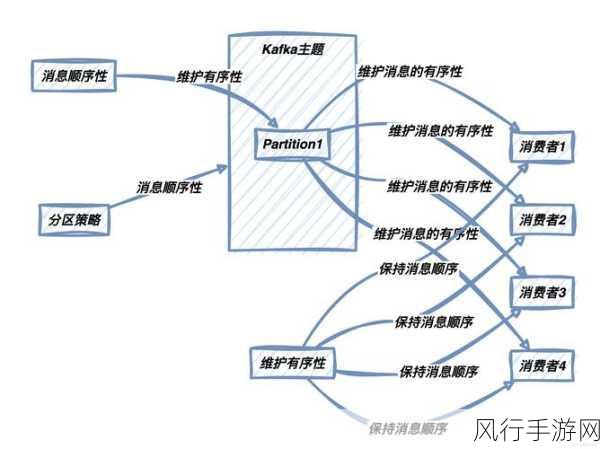

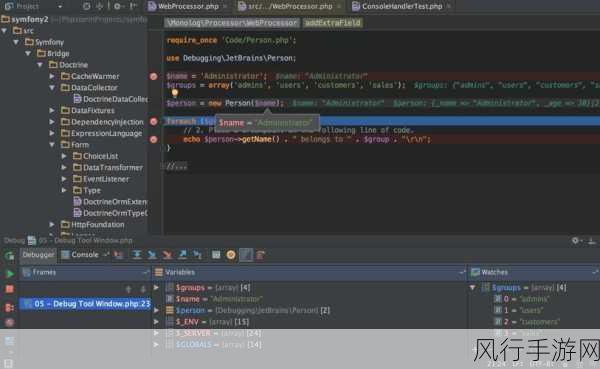

算法层面的优化同样不可忽视,采用更高效的算法来计算图神经网络中的消息传递和聚合操作,或者使用缓存机制来避免重复计算,都能够有效地提升推理速度。

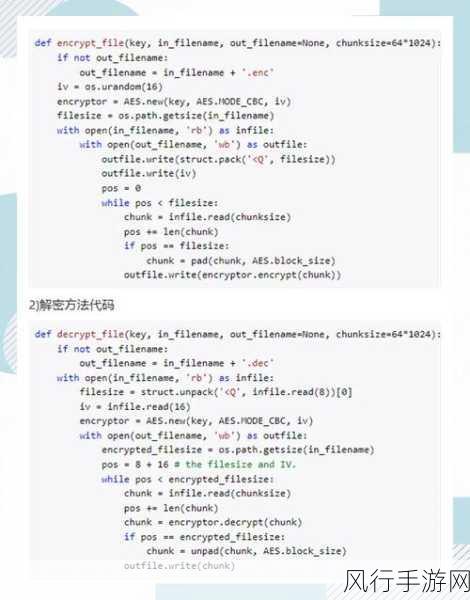

模型的压缩和量化技术也是加速推理的有力武器,通过对模型进行压缩,如知识蒸馏,将大型复杂的模型压缩为较小的模型,同时保持较好的性能,量化技术则将模型的参数从高精度浮点数转换为低精度整数,减少了内存占用和计算量。

在实际应用中,还需要结合具体的业务需求和硬件环境,综合运用上述多种方法,不断进行实验和优化,才能找到最适合的加速策略,从而在保证模型性能的前提下,大幅提升 PyTorch PyG 模型的推理速度,为各种应用提供更高效、更实时的服务。

加速 PyTorch PyG 模型推理是一个综合性的任务,需要从多个角度入手,不断探索和创新,以适应不断发展的应用需求和计算环境。