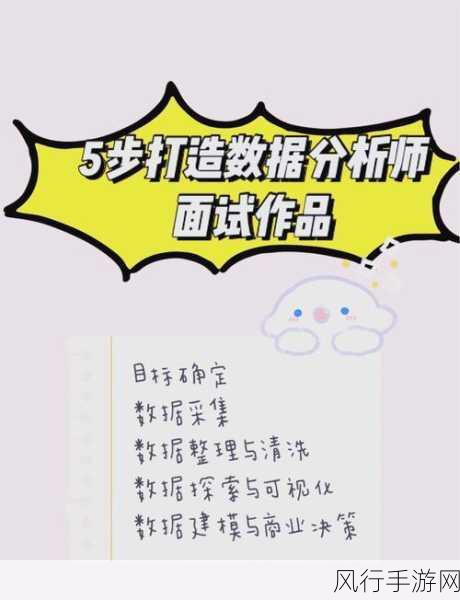

在当今数字化时代,数据成为了企业和研究人员获取有价值信息的重要资源,要从海量的数据中提取有用的知识和洞察,数据预处理是必不可少的关键步骤,在 Python 中进行数据预处理时,我们常常会遭遇一系列难题。

数据质量参差不齐是首要的挑战,现实中的数据可能包含缺失值、错误数据、重复记录等问题,这些低质量的数据会严重影响后续的分析和建模结果,在一个销售数据集中,某些产品的销售数量可能被错误地记录为负数,或者某些客户的信息存在缺失。

数据格式的多样性也给预处理带来了困扰,不同的数据源可能采用不同的格式,如 CSV、JSON、Excel 等,将这些格式各异的数据整合到一起,并转化为统一的、易于处理的格式,需要耗费大量的时间和精力。

特征工程的复杂性也是不容忽视的问题,在数据预处理中,我们需要对数据进行特征提取、转换和选择,以构建适合模型的输入特征,这要求我们对数据的理解深刻,并且具备一定的领域知识。

处理大规模数据时的性能问题也是一个难点,当数据量巨大时,数据的加载、清洗和转换操作可能会变得非常缓慢,甚至导致内存溢出等问题。

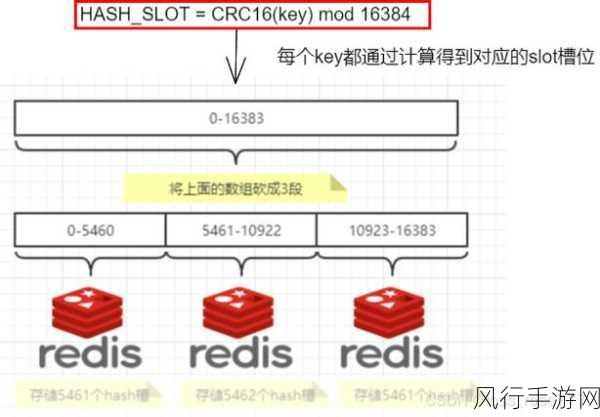

为了应对这些难题,我们可以采取一些有效的策略,对于数据质量问题,可以使用数据清洗技术,如填充缺失值、纠正错误数据、删除重复记录等,在处理数据格式多样性方面,可以借助 Python 丰富的库,如 Pandas 来进行数据的读取和转换,在特征工程方面,通过结合领域知识和机器学习算法,选择合适的特征提取和转换方法,而对于大规模数据的性能问题,可以采用分布式计算框架,如 Spark 来提高处理效率。

Python 数据预处理虽然充满挑战,但通过合理的方法和技术,我们能够克服这些难题,为后续的数据分析和建模工作打下坚实的基础,只有在数据预处理阶段做好充分的准备,才能从数据中挖掘出真正有价值的信息,为决策提供有力的支持。