深入探索 Hadoop 核心组件性能测试的奥秘

Hadoop 作为大数据处理领域的重要框架,其核心组件的性能对于整个系统的运行效率和稳定性至关重要,了解如何对 Hadoop 核心组件进行性能测试,能够帮助我们更好地优化系统,提升数据处理能力。

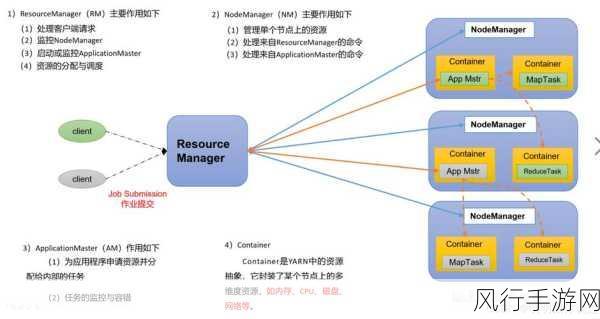

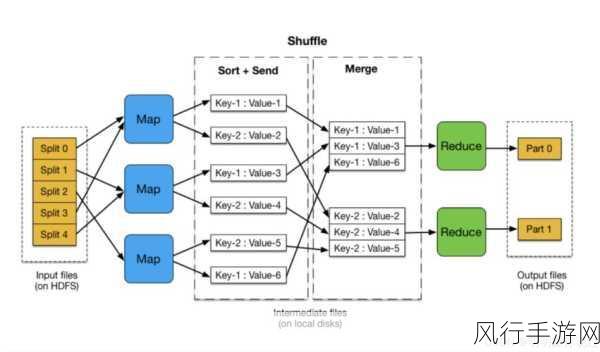

Hadoop 的核心组件包括 HDFS(Hadoop 分布式文件系统)、MapReduce(分布式计算框架)和 YARN(资源管理框架)等,要对这些组件进行性能测试,需要明确测试的目标和指标。

性能测试的目标可能是评估系统在不同负载下的处理能力、响应时间、资源利用率等,常见的测试指标包括数据吞吐量、任务执行时间、内存使用情况、CPU 利用率等。

在进行 Hadoop 核心组件性能测试时,测试环境的搭建是关键的一步,需要准备合适的硬件设备,包括服务器、存储设备等,并安装配置好 Hadoop 相关的软件和依赖,要确保测试环境的网络稳定,避免网络因素对测试结果产生干扰。

测试数据的准备也十分重要,数据的规模、分布、格式等都会影响测试结果,为了获得更准确和有代表性的测试结果,需要根据实际应用场景生成具有一定规模和复杂性的测试数据。

对于 HDFS 的性能测试,可以通过上传、下载、读取和写入大量文件来评估其数据传输速度和存储性能,可以使用工具来监测文件操作的时间和系统资源的使用情况。

MapReduce 的性能测试则可以通过运行不同规模和复杂度的计算任务来进行,观察任务的执行时间、资源消耗以及输出结果的准确性,以判断 MapReduce 在处理数据时的性能表现。

YARN 的性能测试重点关注资源的分配和调度效率,可以模拟不同的作业请求,观察 YARN 如何分配计算资源和处理资源竞争情况。

在测试过程中,要注意记录详细的测试数据和结果,并对结果进行分析和总结,通过对比不同测试场景下的性能数据,找出系统的性能瓶颈和优化方向。

性能测试不是一次性的工作,而是一个持续的过程,随着系统的升级、业务的变化,需要定期进行性能测试,以确保 Hadoop 核心组件能够满足不断增长的业务需求。

对 Hadoop 核心组件进行性能测试是一项复杂但重要的工作,通过科学合理的测试方法和持续的优化,能够让 Hadoop 系统在大数据处理中发挥出更出色的性能。