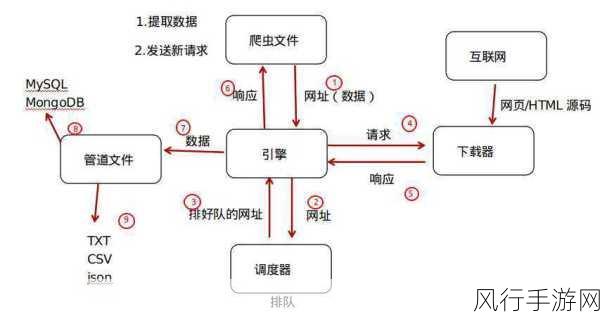

Python 爬虫框架在当今的数据获取领域中发挥着重要作用,要确保其稳定性并非易事。

爬虫框架的稳定性受到多种因素的影响,网络环境的复杂性是其中之一,不稳定的网络连接、频繁的超时和错误响应,都可能导致爬虫任务的中断或失败,目标网站的反爬虫机制也是一大挑战,许多网站会采取各种手段来阻止爬虫的访问,如验证码、IP 封锁等,如果爬虫框架不能有效地应对这些反制措施,就难以稳定运行。

为了保证 Python 爬虫框架的稳定性,合理的请求频率控制至关重要,过于频繁的请求可能会被目标网站视为恶意行为而加以限制,需要根据目标网站的特点和规则,设置适当的请求间隔,模拟真实用户的访问行为,使用随机的请求头信息,包括 User-Agent、Referer 等,可以降低被识别为爬虫的风险。

错误处理机制也是保障稳定性的关键环节,在爬虫运行过程中,不可避免会遇到各种错误,如网络错误、解析错误等,一个完善的错误处理机制能够及时捕获并处理这些错误,避免整个爬虫程序因个别错误而崩溃,当遇到网络超时错误时,可以自动进行重试;对于解析错误,可以记录错误信息并跳过当前页面,继续处理后续任务。

分布式架构的引入能够极大地提升爬虫框架的稳定性和效率,通过将爬虫任务分配到多个节点上并行执行,可以有效地应对大规模的数据抓取需求,分布式架构还能够提供冗余和容错能力,当某个节点出现故障时,其他节点可以继续工作,确保爬虫任务不中断。

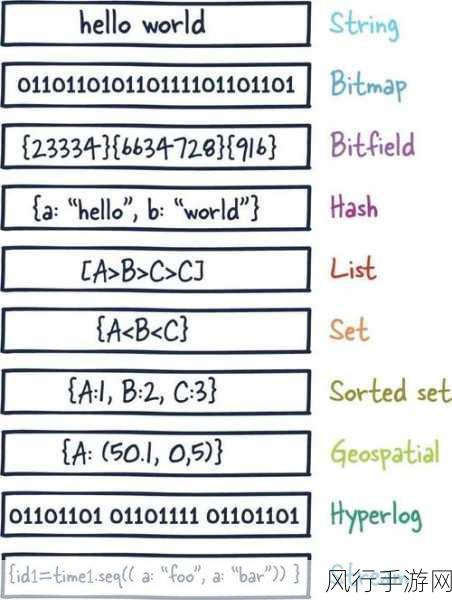

数据存储的优化同样不容忽视,高效的数据库设计和存储方式能够减少数据写入和读取的时间,提高爬虫的整体性能,选择适合爬虫数据特点的数据库,如 MongoDB 或 Redis,并合理设置索引和缓存,能够有效提升数据操作的效率。

监控和日志系统对于保障爬虫框架的稳定性也具有重要意义,通过实时监控爬虫的运行状态、请求响应时间、错误率等指标,可以及时发现潜在的问题并采取相应的措施,详细的日志记录能够帮助我们在出现问题时进行回溯和分析,快速定位故障原因。

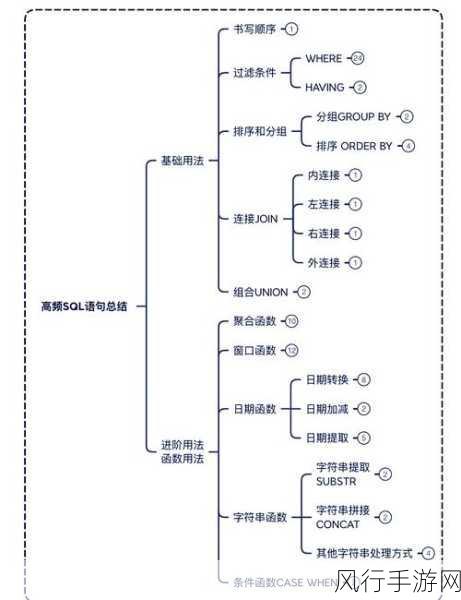

要保证 Python 爬虫框架的稳定性,需要综合考虑网络环境、反爬虫机制、请求频率控制、错误处理、分布式架构、数据存储优化以及监控和日志系统等多个方面,只有在各个环节都做到精心设计和优化,才能构建一个稳定可靠的爬虫框架,为数据获取工作提供有力支持。