在当今数字化的时代,数据的价值日益凸显,而爬虫技术成为了获取数据的重要手段之一,Python 因其简洁易学和丰富的库支持,成为了编写爬虫的热门选择,要想让 Python 编写的爬虫更加高效、稳定和可靠,就需要进行一系列的优化。

编写爬虫时,我们需要充分考虑目标网站的结构和规则,了解网站的页面布局、数据存储方式以及反爬虫机制,有助于我们制定更有针对性的爬取策略,有些网站可能会对频繁的请求进行限制,此时我们就需要合理控制请求的频率,避免被封禁。

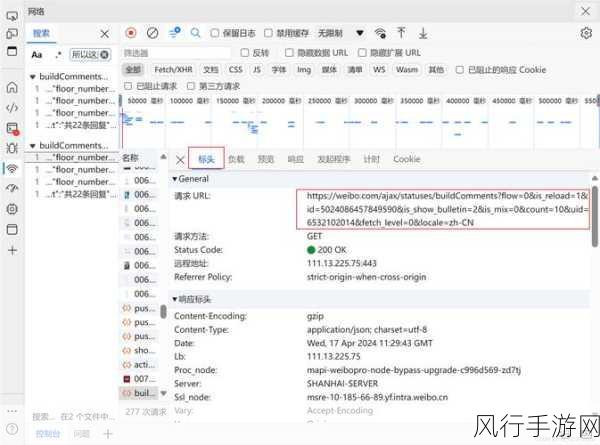

选择合适的网络请求库也至关重要,Python 中有多种网络请求库可供选择,如 requests、urllib 等,不同的库在性能、功能和易用性上可能存在差异,我们需要根据具体的需求和项目特点,选择最适合的库来提高爬虫的效率。

在数据处理方面,优化数据的存储和解析能够显著提升爬虫的性能,对于大量的数据,采用合适的数据结构和数据库进行存储,能够加快数据的读写速度,在解析网页内容时,使用高效的解析库和算法,能够快速准确地提取所需信息。

还有,多线程和异步编程也是优化爬虫的有效手段,通过同时发起多个请求,能够大大提高爬虫的抓取速度,但需要注意的是,过度的并发可能会给服务器带来压力,甚至导致被封禁,所以要合理控制并发量。

设置合理的错误处理机制也是必不可少的,在爬取过程中,可能会遇到各种网络异常、页面结构变化等问题,通过完善的错误处理代码,能够让爬虫在遇到问题时自动重试或者采取其他应对措施,保证爬虫的稳定性和可靠性。

要时刻关注法律法规和道德规范,爬虫的使用必须在合法合规的前提下进行,不得侵犯他人的权益和隐私。

优化 Python 编写的爬虫需要综合考虑多个方面,从请求策略、库的选择、数据处理、并发控制到错误处理等,只有不断地实践和探索,才能编写出高效、稳定且合法合规的爬虫程序,为我们获取有价值的数据提供有力的支持。