在当今数据驱动的时代,数据预处理成为了数据分析和机器学习项目中至关重要的环节,有效的数据预处理不仅能够提高数据质量,还能为后续的分析和建模工作打下坚实的基础,Python 作为一种强大而灵活的编程语言,为数据预处理提供了丰富的工具和库,如何优化 Python 数据预处理流程,以提高效率和效果,是众多数据从业者面临的挑战。

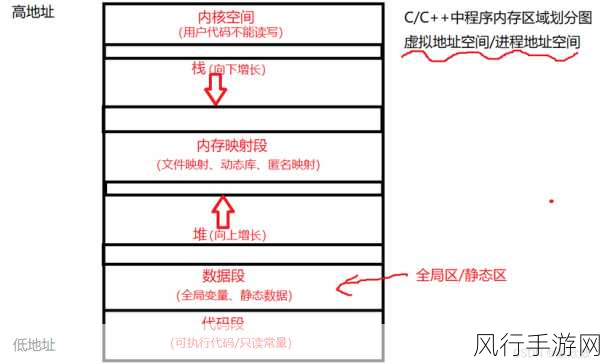

数据预处理涉及多个步骤,包括数据清洗、数据转换、特征工程等,在数据清洗阶段,我们需要处理缺失值、异常值和重复数据,对于缺失值,我们可以采用多种方法进行处理,如删除包含缺失值的行或列、用均值、中位数或众数填充缺失值,或者基于模型预测缺失值,在处理异常值时,需要根据具体情况判断异常值的产生原因,如果是数据录入错误,则需要进行修正;如果是真实存在的极端值,则可以保留或进行适当的变换。

数据转换是为了将数据转换为适合后续分析和建模的格式,常见的数据转换操作包括标准化、归一化、编码分类变量等,标准化可以将数据的分布调整为均值为 0、标准差为 1 的标准正态分布,使得不同特征在数值上具有可比性,归一化则将数据的值映射到特定的区间,如[0, 1],对于分类变量,我们可以使用独热编码或标签编码将其转换为数值形式。

特征工程是数据预处理中非常关键的一步,它直接影响到模型的性能,通过特征提取、特征选择和特征构建,可以从原始数据中获取更有意义和代表性的特征,特征提取可以通过主成分分析(PCA)、线性判别分析(LDA)等方法将高维数据降维到低维空间,同时保留主要的信息,特征选择可以使用过滤法、包裹法或嵌入法来筛选出对目标变量具有较强预测能力的特征,特征构建则是基于原始特征创建新的特征,例如通过计算两个特征的比值或差值来生成新的特征。

在优化 Python 数据预处理流程时,合理选择和使用相关的库和函数是非常重要的,Pandas 库提供了丰富的数据处理功能,如数据读取、数据清理和数据合并等,NumPy 库则擅长数值计算和数组操作,在数据转换和特征工程中经常用到,Scikit-learn 库中的 preprocessing 模块包含了许多常用的数据预处理方法,如标准化、归一化和编码等。

并行计算和缓存技术也可以显著提高数据预处理的效率,对于大规模数据,可以利用 Python 的多进程或多线程库来并行执行数据预处理任务,充分利用多核 CPU 的计算能力,合理使用缓存机制,将处理过的数据保存起来,避免重复计算,也能够节省时间和资源。

优化 Python 数据预处理流程需要综合考虑数据的特点、处理的目标以及可用的工具和技术,通过精心设计和实践,我们能够提高数据预处理的效率和质量,为数据分析和机器学习项目带来更好的结果,不断探索和创新,才能在数据预处理的道路上越走越远,为解决实际问题提供有力的支持。