探索 Hadoop 核心组件的创新应用之旅

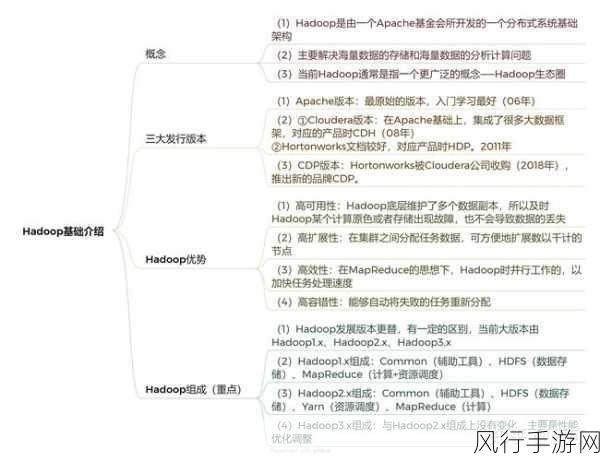

Hadoop 作为大数据处理领域的重要技术框架,其核心组件蕴含着巨大的创新潜力,在当今数字化时代,如何充分挖掘和发挥这些组件的创新应用,成为了众多企业和开发者关注的焦点。

Hadoop 的核心组件包括 HDFS(Hadoop 分布式文件系统)、MapReduce(分布式计算模型)、YARN(资源管理框架)等,这些组件各自具备独特的功能和特点,为大数据处理提供了坚实的基础。

HDFS 是 Hadoop 存储数据的基石,它具有高容错性和可扩展性,传统上,HDFS 主要用于大规模数据的存储,但在创新应用方面,我们可以将其与智能存储技术相结合,实现对数据的更高效管理和访问,通过引入数据压缩和分层存储策略,能够在不影响性能的前提下,大幅降低存储成本。

MapReduce 作为 Hadoop 的计算引擎,在处理大规模数据的批处理任务方面表现出色,为了适应更复杂的业务需求,我们可以对 MapReduce 进行优化和扩展,采用混合计算模式,将 MapReduce 与实时计算框架(如 Spark)相结合,实现批处理和流处理的无缝衔接,从而满足不同场景下的数据处理要求。

YARN 作为资源管理框架,负责整个集群的资源分配和调度,创新应用中,可以利用 YARN 的动态资源分配特性,实现资源的精细化管理,根据不同任务的优先级和资源需求,实时调整资源分配策略,提高集群的整体资源利用率。

Hadoop 核心组件的创新应用还体现在与新兴技术的融合上,将人工智能技术应用于 Hadoop 数据处理流程中,通过机器学习算法对数据进行分析和预测,为企业决策提供更有价值的信息。

Hadoop 核心组件的创新应用有着广阔的空间和潜力,我们需要不断探索和尝试新的方法和技术,充分发挥 Hadoop 的优势,为大数据处理带来更多的可能性,助力企业在数字化时代实现更好的发展和竞争优势。