Python 网络爬虫,自动化的可能性与挑战

Python 网络爬虫是当前数据获取领域的热门话题之一,网络爬虫作为一种能够自动获取网页信息的技术手段,为我们从海量的网络数据中提取有价值的内容提供了极大的便利,Python 网络爬虫能否真正实现自动化呢?

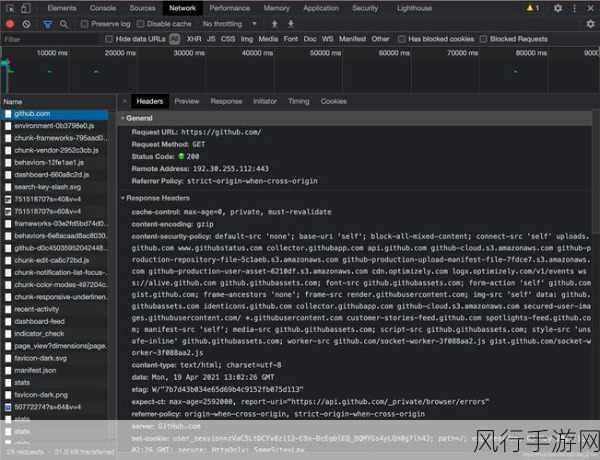

要回答这个问题,我们首先需要了解什么是 Python 网络爬虫,它是一段用 Python 语言编写的程序,能够模拟人类在浏览器中的行为,自动访问网页、提取数据并进行处理,通过巧妙地运用 Python 的各种库和工具,如 Requests、BeautifulSoup、Scrapy 等,开发者可以轻松地构建出功能强大的爬虫程序。

Python 网络爬虫在实现自动化方面具有诸多优势,其语法简洁易懂,容易上手,即使是编程新手也能够在较短的时间内掌握基本的爬虫技巧,Python 拥有丰富的第三方库,这些库提供了各种实用的功能和方法,大大降低了开发爬虫的难度。

要实现完全的自动化并非一帆风顺,网络环境的复杂性是一个重要的挑战,不同的网站可能采用不同的反爬虫策略,如验证码、IP 封禁、访问频率限制等,这就需要爬虫开发者具备足够的技术能力和经验,来应对这些反制措施。

法律和道德规范也是必须要考虑的因素,在使用网络爬虫获取数据时,必须确保遵守相关的法律法规和网站的使用条款,未经授权地爬取敏感信息或对网站造成负担,都可能引发法律问题。

数据的质量和准确性也是一个关键问题,自动化爬虫可能会由于网页结构的变化、数据格式的不一致等原因,导致获取的数据存在错误或不完整,需要对爬取的数据进行有效的清洗和验证。

Python 网络爬虫在一定程度上能够实现自动化,但需要开发者具备扎实的技术基础、对法律和道德规范的敬畏之心,以及对数据质量的严格把控,只有在合理、合法、合规的前提下,充分发挥 Python 网络爬虫的优势,才能为我们的工作和研究带来真正有价值的信息。

随着技术的不断发展和完善,相信 Python 网络爬虫在自动化方面将会取得更大的突破,但无论如何,我们都应该始终牢记,技术是为了服务人类,而不是给社会带来负面影响,让我们以负责任的态度,用好 Python 网络爬虫这一强大的工具,为推动社会的进步和发展贡献力量。