Python Scrapy 爬虫中请求头设置的深度指南

在当今数字化的时代,数据的获取和分析变得至关重要,Python 的 Scrapy 框架因其强大的功能,成为了众多开发者进行爬虫开发的首选工具,而在使用 Scrapy 进行爬虫开发时,请求头的设置是一个关键环节,它直接影响到爬虫的效率和成功率。

如何在 Python Scrapy 爬虫中进行请求头的设置呢?这需要我们对 Scrapy 的工作原理和相关的网络知识有一定的了解。

请求头包含了许多重要的信息,比如用户代理、接受语言、编码等,通过合理设置请求头,我们可以模拟真实的用户请求,降低被网站反爬虫机制识别和封禁的风险。

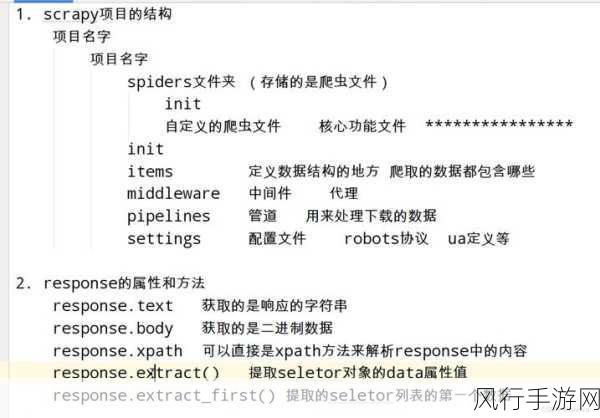

在 Scrapy 中,我们可以通过修改 settings.py 文件来设置请求头,我们可以定义一个名为 DEFAULT_REQUEST_HEADERS 的字典,在其中添加我们需要的请求头信息。

DEFAULT_REQUEST_HEADERS = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9',

'Accept-Language': 'en-US,en;q=0.9',

'Accept-Encoding': 'gzip, deflate, br'

}上述代码中,我们设置了常见的请求头信息,包括用户代理、接受类型、语言和编码等,需要注意的是,用户代理的选择要尽量模拟真实的浏览器,避免使用过于明显的爬虫标识。

我们还可以根据具体的网站需求,动态地设置请求头,某些网站可能需要特定的认证信息或者其他自定义的头部字段,我们可以在发送请求时通过修改 Request 对象的 headers 属性来实现。

在 Python Scrapy 爬虫中,请求头的设置是一项重要而细致的工作,需要我们不断地尝试和优化,以找到最适合目标网站的设置方式,从而确保爬虫的稳定运行和高效数据获取。

在实际开发过程中,我们还应该遵守相关的法律法规和网站的使用规则,合理合法地获取数据,为数据的分析和应用提供有力的支持。