探索 PyTorch 模型训练准确率提升的秘诀

PyTorch 作为深度学习领域备受青睐的框架,在模型训练中追求更高的准确率是众多开发者和研究者的共同目标,要提升 PyTorch 模型训练的准确率,并非一蹴而就,需要从多个方面进行精心的设计和优化。

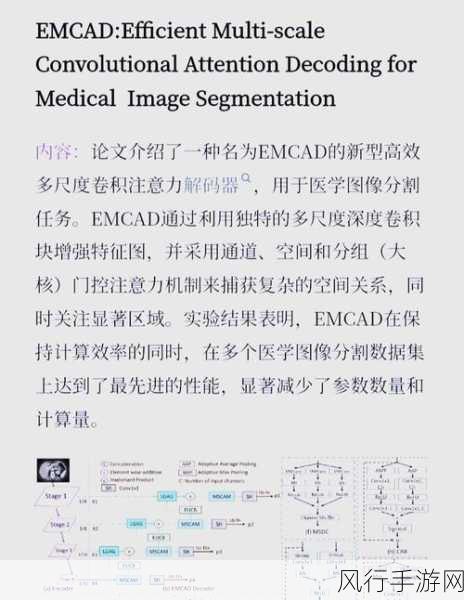

模型的架构选择至关重要,不同的任务和数据特点适合不同类型的模型架构,对于图像识别任务,卷积神经网络(CNN)常常能取得较好的效果;而对于序列数据,循环神经网络(RNN)及其变体如长短期记忆网络(LSTM)和门控循环单元(GRU)则更为适用,在选择模型架构时,需要充分考虑数据的特征、任务的复杂性以及计算资源的限制。

数据的质量和预处理直接影响模型的训练效果,高质量、多样化且具有代表性的数据能够为模型学习提供丰富的信息,在数据预处理阶段,常见的操作包括数据清洗、归一化、标准化等,数据增强技术如翻转、旋转、裁剪等可以增加数据的多样性,有助于模型更好地泛化。

超参数的调优是提升准确率的关键环节,学习率、正则化参数、迭代次数等超参数的选择对模型性能有着显著影响,可以通过网格搜索、随机搜索或者更先进的基于模型的超参数优化方法来找到最优的超参数组合,监控模型在训练集和验证集上的损失和准确率变化,及时调整超参数,避免过拟合或欠拟合的情况发生。

优化算法的选择也不容忽视,常见的优化算法如随机梯度下降(SGD)、Adagrad、Adadelta、RMSProp 和 Adam 等各有特点,Adam 算法通常在大多数情况下表现良好,但对于某些特定的问题,其他算法可能更具优势,根据模型和数据的特点,尝试不同的优化算法,并调整其相关参数,可能会带来准确率的提升。

模型的融合和集成也是一种有效的策略,可以训练多个不同的模型,然后通过平均、加权平均或者投票等方式进行集成,这样可以综合多个模型的优势,降低单个模型的不确定性,从而提高整体的准确率。

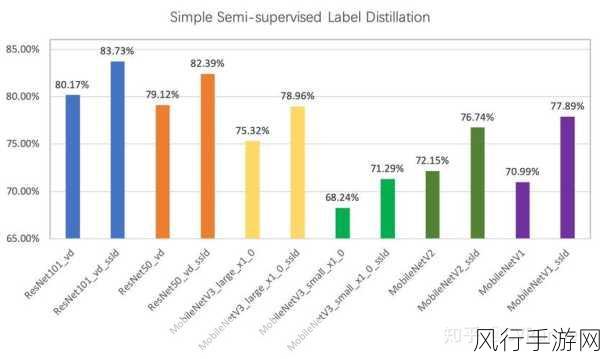

利用迁移学习也是一个明智之举,在大规模数据集上预训练的模型往往学到了通用的特征表示,将其在特定任务上进行微调,可以大大减少训练时间并提高准确率。

提升 PyTorch 模型训练的准确率需要综合考虑模型架构、数据处理、超参数调优、优化算法选择、模型融合和集成以及迁移学习等多个方面,不断地试验和改进,结合具体问题和数据特点,才能找到最适合的方法,实现模型准确率的显著提升,在深度学习的道路上,持续的探索和创新是取得优异成果的关键。